소개

지금까지 웹에서의 오디오는 상당히 원시적이었으며, 최근까지도 Flash나 QuickTime과 같은 플러그인을 통해 제공되어야 했습니다. HTML5의

audio

요소가 도입되면서

기본적인 스트리밍 오디오 재생이 가능해졌습니다. 하지만 이로는 더 복잡한 오디오 애플리케이션을 처리하기에는 충분하지 않습니다. 정교한 웹 기반 게임이나 상호작용 애플리케이션을 위해서는

또 다른 솔루션이 필요합니다. 이 명세의 목표는 최신 게임 오디오 엔진에서 제공하는 기능뿐만 아니라, 현대 데스크톱 오디오 제작 애플리케이션에서 볼 수 있는 믹싱, 처리, 필터링 작업들을

포함하는 것입니다.

API는 다양한 사용 사례 [webaudio-usecases]를 염두에 두고 설계되었습니다. 이상적으로는 최적화된 C++ 엔진을 스크립트로 제어하여 브라우저에서 실행할 수 있는 어떤 사용 사례도 지원할 수 있어야 합니다. 물론, 최신 데스크톱 오디오 소프트웨어는 매우 고도화된 기능을 제공하며, 일부는 이 시스템으로 구축하기 어렵거나 불가능할 수도 있습니다. 애플의 Logic Audio와 같은 애플리케이션은 외부 MIDI 컨트롤러 지원, 임의의 플러그인 오디오 이펙트 및 신디사이저, 고도로 최적화된 디스크 직접 읽기/쓰기, 긴밀하게 통합된 타임 스트레칭 등 다양한 고급 기능을 탑재하고 있습니다. 그럼에도 불구하고, 제안된 시스템은 상당히 복잡한 게임과 상호작용 애플리케이션(음악 애플리케이션 포함)을 충분히 지원할 수 있으며, WebGL에서 제공하는 고급 그래픽 기능과도 훌륭하게 결합될 수 있습니다. API는 추후 더 고급 기능을 확장할 수 있도록 설계되었습니다.

기능

API가 지원하는 주요 기능은 다음과 같습니다:

-

모듈형 라우팅을 통한 간단하거나 복잡한 믹싱/이펙트 아키텍처.

-

내부 처리를 위한 32비트 부동 소수점 사용으로 높은 다이내믹 레인지 제공.

-

샘플 단위 정확도의 일정 사운드 재생 및 저지연으로 드럼 머신이나 시퀀서 등 매우 높은 리듬 정밀도를 요구하는 음악 애플리케이션을 지원. 이펙트의 동적 생성도 포함됩니다.

-

오디오 파라미터 자동화 (엔벨로프, 페이드인/페이드아웃, 그래뉼러 이펙트, 필터 스윕, LFO 등).

-

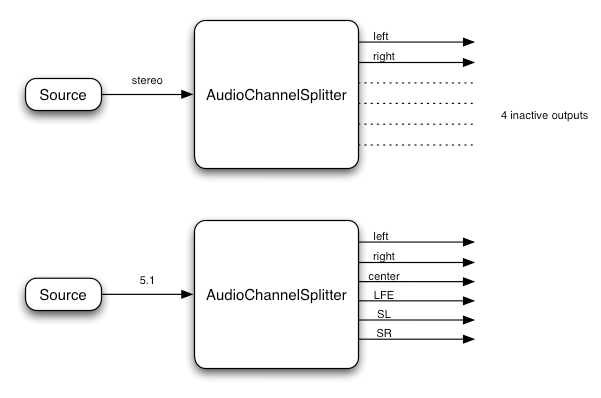

오디오 스트림의 채널을 유연하게 처리하여 분리 및 병합 가능.

-

audio또는videomedia element의 오디오 소스 처리. -

MediaStream을 통한 라이브 오디오 입력 처리,getUserMedia()와 함께 사용. -

WebRTC와의 통합

-

MediaStreamTrackAudioSourceNode와 [webrtc]를 통해 원격 피어로부터 받은 오디오 처리. -

MediaStreamAudioDestinationNode와 [webrtc]를 통해 생성/처리된 오디오 스트림을 원격 피어로 전송.

-

-

오디오 스트림 합성 및 스크립트를 통한 직접 처리.

-

공간화 오디오로 다양한 3D 게임 및 몰입형 환경 지원:

-

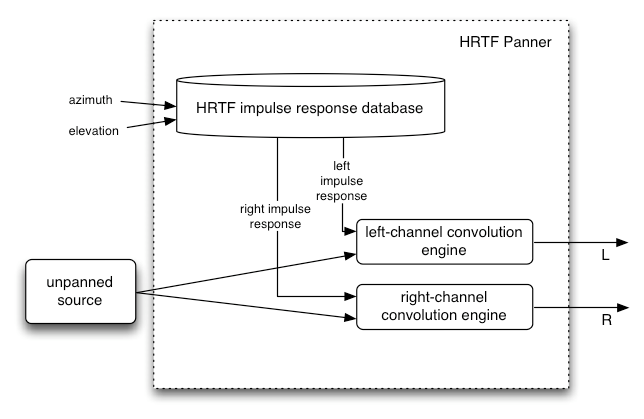

패닝 모델: equalpower, HRTF, 패스스루

-

거리 감쇠(Attenuation)

-

사운드 콘(Sound Cones)

-

차단/가림(Obstruction / Occlusion)

-

소스/리스너 기반

-

-

광범위한 선형 이펙트를 위한 컨볼루션 엔진, 특히 고품질의 룸 이펙트. 가능한 효과 예시는 다음과 같습니다:

-

작은/큰 방

-

대성당

-

콘서트홀

-

동굴

-

터널

-

복도

-

숲

-

원형극장

-

문을 통해 들리는 먼 방의 소리

-

극단적인 필터

-

이상한 역효과

-

극단적인 콤 필터 이펙트

-

-

믹스 전체 제어 및 음색 개선을 위한 다이내믹스 컴프레션

-

효율적인 바이쿼드 필터로 로우패스, 하이패스 및 기타 일반 필터 제공.

-

왜곡 및 기타 비선형 이펙트를 위한 웨이브쉐이핑 효과

-

오실레이터

모듈형 라우팅

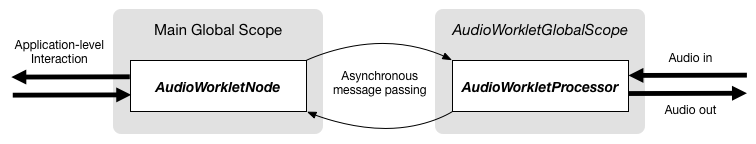

모듈형 라우팅은 서로 다른 AudioNode

객체 간 임의의 연결을 허용합니다. 각 노드는 입력(inputs) 및/또는 출력(outputs)을 가질 수 있습니다.

소스 노드(source node)는 입력이 없고

출력이 하나입니다.

목적지 노드(destination

node)는 입력이 하나이고 출력이 없습니다. 필터와 같은 다른 노드는 소스와 목적지 노드 사이에 배치될 수 있습니다. 개발자는 두 객체를 연결할 때 저수준 스트림 포맷에 대해

걱정할 필요가 없으며, 알아서 적절하게 처리됩니다.

예를 들어, 모노 오디오 스트림이 스테레오 입력에 연결되면 적절하게 좌우 채널로 믹싱됩니다.

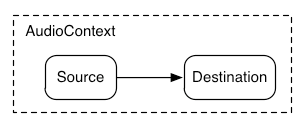

가장 단순한 경우, 하나의 소스를 바로 출력으로 라우팅할 수 있습니다.

모든 라우팅은 단일 AudioContext

내의 단일 AudioDestinationNode에서

발생합니다:

이 단순 라우팅을 설명하는 예시로, 하나의 사운드를 재생하는 간단한 코드입니다:

const context= new AudioContext(); function playSound() { const source= context. createBufferSource(); source. buffer= dogBarkingBuffer; source. connect( context. destination); source. start( 0 ); }

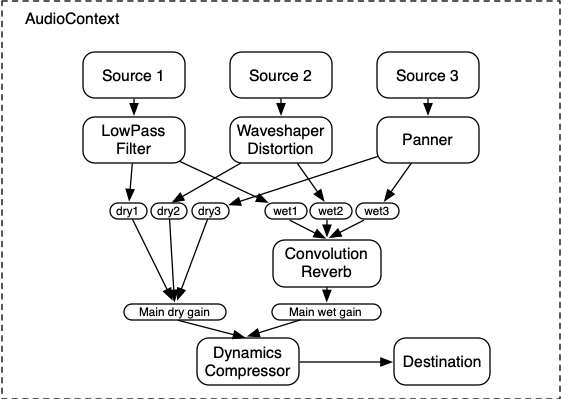

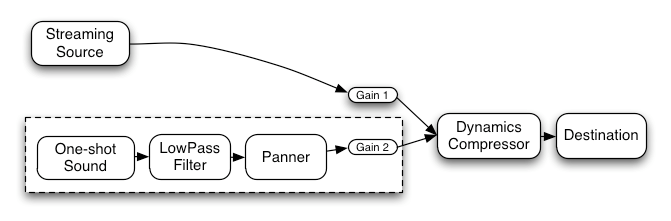

다음은 세 개의 소스와 컨볼루션 리버브, 그리고 최종 출력 단계에 다이내믹스 컴프레서를 포함한 더 복잡한 예시입니다:

let context; let compressor; let reverb; let source1, source2, source3; let lowpassFilter; let waveShaper; let panner; let dry1, dry2, dry3; let wet1, wet2, wet3; let mainDry; let mainWet; function setupRoutingGraph() { context= new AudioContext(); // 이펙트 노드 생성 lowpassFilter= context. createBiquadFilter(); waveShaper= context. createWaveShaper(); panner= context. createPanner(); compressor= context. createDynamicsCompressor(); reverb= context. createConvolver(); // 메인 wet/dry 생성 mainDry= context. createGain(); mainWet= context. createGain(); // 최종 컴프레서를 목적지에 연결 compressor. connect( context. destination); // 메인 dry/wet를 컴프레서에 연결 mainDry. connect( compressor); mainWet. connect( compressor); // 리버브를 메인 wet에 연결 reverb. connect( mainWet); // 소스 생성 source1= context. createBufferSource(); source2= context. createBufferSource(); source3= context. createOscillator(); source1. buffer= manTalkingBuffer; source2. buffer= footstepsBuffer; source3. frequency. value= 440 ; // source1 연결 dry1= context. createGain(); wet1= context. createGain(); source1. connect( lowpassFilter); lowpassFilter. connect( dry1); lowpassFilter. connect( wet1); dry1. connect( mainDry); wet1. connect( reverb); // source2 연결 dry2= context. createGain(); wet2= context. createGain(); source2. connect( waveShaper); waveShaper. connect( dry2); waveShaper. connect( wet2); dry2. connect( mainDry); wet2. connect( reverb); // source3 연결 dry3= context. createGain(); wet3= context. createGain(); source3. connect( panner); panner. connect( dry3); panner. connect( wet3); dry3. connect( mainDry); wet3. connect( reverb); // 소스 시작 source1. start( 0 ); source2. start( 0 ); source3. start( 0 ); }

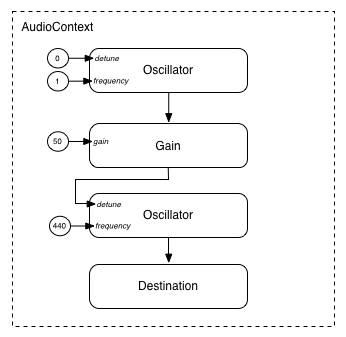

모듈형 라우팅은 AudioNode의 출력을

AudioParam

파라미터에 연결하여

다른 AudioNode의

동작을 제어할 수도 있습니다. 이 경우,

노드의 출력은 입력 신호가 아닌 변조 신호로 작동할 수 있습니다.

function setupRoutingGraph() { const context= new AudioContext(); // 변조 신호를 공급하는 저주파 오실레이터 생성 const lfo= context. createOscillator(); lfo. frequency. value= 1.0 ; // 변조될 고주파 오실레이터 생성 const hfo= context. createOscillator(); hfo. frequency. value= 440.0 ; // 변조 신호의 진폭(Amplitude)을 결정하는 게인 노드 생성 const modulationGain= context. createGain(); modulationGain. gain. value= 50 ; // 그래프 구성 및 오실레이터 시작 lfo. connect( modulationGain); modulationGain. connect( hfo. detune); hfo. connect( context. destination); hfo. start( 0 ); lfo. start( 0 ); }

API 개요

정의된 인터페이스는 다음과 같습니다:

-

AudioContext 인터페이스는

AudioNode들 간의 연결을 나타내는 오디오 신호 그래프를 포함합니다. -

AudioNode인터페이스는 오디오 소스, 오디오 출력, 그리고 중간 처리 모듈을 나타냅니다.AudioNode들은 모듈형 방식으로 동적으로 서로 연결될 수 있습니다.AudioNode들은AudioContext의 컨텍스트 내에 존재합니다. -

AnalyserNode인터페이스는, 음악 비주얼라이저나 기타 시각화 애플리케이션에서 사용되는AudioNode입니다. -

AudioBuffer인터페이스는, 메모리에 상주하는 오디오 자산을 다루기 위한 것으로, 일회성 사운드 또는 긴 오디오 클립을 나타낼 수 있습니다. -

AudioBufferSourceNode인터페이스는,AudioNode로서 AudioBuffer에서 오디오를 생성합니다. -

AudioDestinationNode인터페이스는,AudioNode의 하위 클래스로 모든 렌더링된 오디오의 최종 목적지를 나타냅니다. -

AudioParam인터페이스는,AudioNode의 볼륨 등 개별 동작을 제어합니다. -

AudioListener인터페이스는,PannerNode와 함께 공간화에 사용됩니다. -

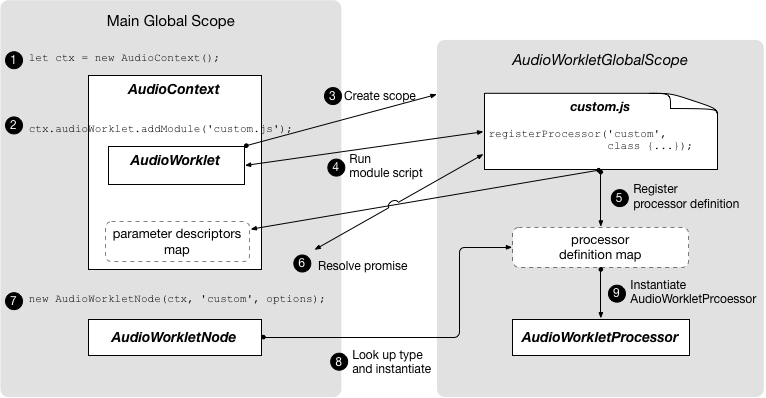

AudioWorklet인터페이스는 스크립트를 직접 이용해 오디오를 처리할 수 있는 커스텀 노드를 생성하는 팩토리 역할을 합니다. -

AudioWorkletGlobalScope인터페이스는 AudioWorkletProcessor 처리 스크립트가 실행되는 컨텍스트입니다. -

AudioWorkletNode인터페이스는, AudioWorkletProcessor에서 처리되는AudioNode를 나타냅니다. -

AudioWorkletProcessor인터페이스는 오디오 워커 내부의 단일 노드 인스턴스를 나타냅니다. -

BiquadFilterNode인터페이스는, 흔히 사용되는 저차 필터(예시:)-

로우패스

-

하이패스

-

밴드패스

-

로우 셸프

-

하이 셸프

-

피킹

-

노치

-

올패스

-

-

ChannelMergerNode인터페이스는, 여러 오디오 스트림의 채널을 하나의 오디오 스트림으로 결합하는AudioNode입니다. -

ChannelSplitterNode인터페이스는, 라우팅 그래프 내 오디오 스트림의 개별 채널에 접근하는AudioNode입니다. -

ConstantSourceNode인터페이스는,AudioNode로 명목상 일정한 출력값을 생성하며,AudioParam으로 값 자동화가 가능합니다. -

ConvolverNode인터페이스는, 콘서트홀 등의 실시간 선형 이펙트를 적용하는AudioNode입니다. -

DynamicsCompressorNode인터페이스는, 다이내믹스 컴프레션에 사용되는AudioNode입니다. -

IIRFilterNode인터페이스는, 범용 IIR 필터를 위한AudioNode입니다. -

MediaElementAudioSourceNode인터페이스는,AudioNode로서audio,video등 미디어 요소의 오디오 소스입니다. -

MediaStreamAudioSourceNode인터페이스는, 라이브 오디오 입력이나 원격 피어의MediaStream에서 오디오 소스를 제공하는AudioNode입니다. -

MediaStreamTrackAudioSourceNode인터페이스는,AudioNode로서MediaStreamTrack의 오디오 소스입니다. -

MediaStreamAudioDestinationNode인터페이스는,AudioNode로서MediaStream에 오디오를 출력하여 원격 피어로 전송합니다. -

PannerNode인터페이스는, 3D 공간에서 오디오의 위치를 지정하는AudioNode입니다. -

PeriodicWave인터페이스는OscillatorNode에서 사용할 사용자 지정 주기 파형을 명시합니다. -

OscillatorNode인터페이스는, 주기적 파형을 생성하는AudioNode입니다. -

StereoPannerNode인터페이스는, 스테레오 스트림에서 오디오 입력을 equal-power 방식으로 위치시키는AudioNode입니다. -

WaveShaperNode인터페이스는, 왜곡 및 기타 미묘한 웜 효과를 위한 비선형 웨이브쉐이핑을 적용하는AudioNode입니다.

Web Audio API에서 폐지(deprecated)되었지만, 대체 기능의 구현 경험을 위해 아직 제거되지 않은 기능도 있습니다:

-

ScriptProcessorNode인터페이스는, 스크립트를 직접 사용하여 오디오를 생성하거나 처리하는AudioNode입니다. -

AudioProcessingEvent인터페이스는ScriptProcessorNode객체에서 사용되는 이벤트 타입입니다.

1. 오디오 API

1.1.

BaseAudioContext

인터페이스

이 인터페이스는 AudioNode 객체들과

그 연결을 나타냅니다.

신호를 AudioDestinationNode로

임의 라우팅할 수 있습니다.

노드는 컨텍스트에서 생성되며 서로 연결됩니다.

BaseAudioContext는

직접 인스턴스화되지 않고,

구체적 인터페이스인 AudioContext

(실시간 렌더링용)와 OfflineAudioContext

(오프라인 렌더링용)에서 확장됩니다.

BaseAudioContext는

내부 슬롯 [[pending promises]]로

생성되며, 이는 초기에는 빈 순서 리스트의 promise입니다.

각 BaseAudioContext는

고유한

미디어 요소 이벤트 태스크 소스를 갖습니다.

또한 BaseAudioContext는

여러 프라이빗 슬롯 [[rendering thread state]]와

[[control thread state]]를 가지며,

이 값은 AudioContextState에서

가져오고, 둘 다 초기값은 "suspended" 입니다.

그리고 프라이빗 슬롯 [[render quantum size]]도 가지며, 이는

부호 없는 정수입니다.

enum {AudioContextState "suspended" ,"running" ,"closed" };

| 열거값 | 설명 |

|---|---|

"suspended"

| 이 컨텍스트는 현재 일시 정지됨(컨텍스트 시간이 진행되지 않으며, 오디오 하드웨어가 꺼지거나 해제될 수 있음). |

"running"

| 오디오가 처리되고 있음. |

"closed"

| 이 컨텍스트는 해제되어 더 이상 오디오를 처리할 수 없습니다. 모든 시스템 오디오 리소스가 해제됨. |

enum {AudioContextRenderSizeCategory "default" ,"hardware" };

| 열거형 설명 | |

|---|---|

"default"

| AudioContext의 렌더 퀀텀 크기는 128 프레임의 기본값입니다. |

"hardware"

|

User-Agent가 현재 설정에 가장 적합한 렌더 퀀텀 크기를 선택합니다.

참고: 이는 호스트 정보를 노출하며, 핑거프린팅에 사용될 수 있습니다. |

callback DecodeErrorCallback =undefined (DOMException );error callback DecodeSuccessCallback =undefined (AudioBuffer ); [decodedData Exposed =Window ]interface BaseAudioContext :EventTarget {readonly attribute AudioDestinationNode destination ;readonly attribute float sampleRate ;readonly attribute double currentTime ;readonly attribute AudioListener listener ;readonly attribute AudioContextState state ;readonly attribute unsigned long renderQuantumSize ; [SameObject ,SecureContext ]readonly attribute AudioWorklet audioWorklet ;attribute EventHandler onstatechange ;AnalyserNode createAnalyser ();BiquadFilterNode createBiquadFilter ();AudioBuffer createBuffer (unsigned long ,numberOfChannels unsigned long ,length float );sampleRate AudioBufferSourceNode createBufferSource ();ChannelMergerNode createChannelMerger (optional unsigned long numberOfInputs = 6);ChannelSplitterNode createChannelSplitter (optional unsigned long numberOfOutputs = 6);ConstantSourceNode createConstantSource ();ConvolverNode createConvolver ();DelayNode createDelay (optional double maxDelayTime = 1.0);DynamicsCompressorNode createDynamicsCompressor ();GainNode createGain ();IIRFilterNode createIIRFilter (sequence <double >,feedforward sequence <double >);feedback OscillatorNode createOscillator ();PannerNode createPanner ();PeriodicWave createPeriodicWave (sequence <float >,real sequence <float >,imag optional PeriodicWaveConstraints = {});constraints ScriptProcessorNode createScriptProcessor (optional unsigned long bufferSize = 0,optional unsigned long numberOfInputChannels = 2,optional unsigned long numberOfOutputChannels = 2);StereoPannerNode createStereoPanner ();WaveShaperNode createWaveShaper ();Promise <AudioBuffer >decodeAudioData (ArrayBuffer ,audioData optional DecodeSuccessCallback ?,successCallback optional DecodeErrorCallback ?); };errorCallback

1.1.1. 속성

audioWorklet, 타입 AudioWorklet, 읽기 전용-

Worklet객체에 접근할 수 있게 해주며, [HTML]과AudioWorklet에 정의된 알고리즘을 통해AudioWorkletProcessor클래스 정의를 포함한 스크립트를 가져올 수 있습니다. currentTime, 타입 double, 읽기 전용-

이 값은 컨텍스트 렌더링 그래프가 가장 최근에 처리한 오디오 블록에서 마지막 샘플-프레임 바로 다음에 해당하는 초 단위 시간입니다. 렌더링 그래프가 아직 오디오 블록을 처리하지 않았다면

currentTime값은 0입니다.currentTime의 시간 좌표계에서 0 값은 그래프가 처음 처리한 첫 블록의 첫 번째 샘플-프레임을 의미합니다. 이 좌표계에서 경과 시간은BaseAudioContext가 생성한 오디오 스트림의 경과 시간과 일치합니다. 이는 시스템의 다른 시계와 동기화되지 않을 수 있습니다. (OfflineAudioContext의 경우, 스트림이 실제 장치에서 재생되지 않으므로 실시간과의 근사치조차 없습니다.)Web Audio API에서 모든 예약된 시간은

currentTime값을 기준으로 합니다.BaseAudioContext가 "running" 상태일 때, 이 속성 값은 단조롭게 증가하며, 렌더링 스레드에 의해 일정하게 갱신됩니다. 이는 하나의 렌더 퀀텀에 해당합니다. 따라서 실행 중인 컨텍스트에서는currentTime이 오디오 블록을 처리하면서 꾸준히 증가하며, 항상 다음에 처리될 오디오 블록의 시작 시간을 나타냅니다. 또한, 현재 상태에서 예약된 변경이 적용될 수 있는 가장 이른 시간입니다.currentTime은 반환되기 전에 제어 스레드에서 원자적으로 읽어야 합니다. destination, 타입 AudioDestinationNode, 읽기 전용-

모든 오디오의 최종 목적지를 나타내는 입력이 하나인

AudioDestinationNode입니다. 보통 실제 오디오 하드웨어를 의미합니다.AudioNode로 오디오를 렌더링하는 모든 노드는 직접 또는 간접적으로destination에 연결됩니다. listener, 타입 AudioListener, 읽기 전용-

3D 공간화에 사용되는

AudioListener입니다. onstatechange, 타입 EventHandler-

AudioContext의 상태가 변경되었을 때(즉, 해당 promise가 resolve될 때)

BaseAudioContext에 디스패치되는 이벤트의 이벤트 핸들러를 설정하는 속성입니다. 이 이벤트 핸들러의 이벤트 타입은statechange입니다.Event인터페이스를 사용하는 이벤트가 이벤트 핸들러에 디스패치되며, 이벤트 핸들러는 AudioContext의 상태를 직접 조회할 수 있습니다. 새로 생성된 AudioContext는 항상suspended상태로 시작하며, 상태가 변경될 때마다 statechange 이벤트가 발생합니다. 이 이벤트는complete이벤트가 발생하기 전에 먼저 발생합니다. sampleRate, 타입 float, 읽기 전용-

BaseAudioContext가 오디오를 처리하는 샘플 레이트(초당 샘플-프레임 수)입니다. 컨텍스트 내 모든AudioNode들이 이 샘플 레이트로 동작한다고 가정합니다. 이 조건에서는 샘플 레이트 변환기나 "varispeed" 프로세서는 실시간 처리에서는 지원되지 않습니다. 나이퀴스트 주파수(Nyquist frequency)는 이 샘플 레이트 값의 절반입니다. state, 타입 AudioContextState, 읽기 전용-

BaseAudioContext의 현재 상태를 설명합니다. 이 속성을 가져오면[[control thread state]]슬롯의 내용을 반환합니다. renderQuantumSize, 타입 unsigned long, 읽기 전용-

이 속성을 가져오면

[[render quantum size]]슬롯의 값을 반환합니다.

1.1.2. 메서드

createAnalyser()-

팩토리 메서드로,

AnalyserNode를 생성합니다.파라미터 없음.반환 타입:AnalyserNode createBiquadFilter()-

팩토리 메서드로,

BiquadFilterNode를 생성합니다. 2차 필터로, 여러 일반적인 필터 타입 중 하나로 구성할 수 있습니다.파라미터 없음.반환 타입:BiquadFilterNode createBuffer(numberOfChannels, length, sampleRate)-

지정된 크기의 AudioBuffer를 생성합니다. 버퍼의 오디오 데이터는 0으로 초기화(무음)됩니다. 파라미터가 음수, 0, 또는 허용 범위를 벗어나면

NotSupportedError예외가 반드시 발생해야 합니다.BaseAudioContext.createBuffer() 메서드의 인수. 파라미터 타입 Nullable Optional 설명 numberOfChannelsunsigned long✘ ✘ 버퍼에 포함될 채널 수를 결정합니다. 구현체는 최소 32채널을 지원해야 합니다. lengthunsigned long✘ ✘ 샘플 프레임 단위로 버퍼의 크기를 결정합니다. 최소값은 1이어야 합니다. sampleRatefloat✘ ✘ 버퍼 내 선형 PCM 오디오 데이터의 샘플 레이트(초당 샘플 프레임 수)를 설명합니다. 구현체는 최소 8000~96000의 샘플레이트 범위를 지원해야 합니다. 반환 타입:AudioBuffer createBufferSource()-

팩토리 메서드로,

AudioBufferSourceNode를 생성합니다.파라미터 없음.반환 타입:AudioBufferSourceNode createChannelMerger(numberOfInputs)-

팩토리 메서드로,

ChannelMergerNode를 생성합니다. 채널 병합을 나타냅니다.IndexSizeError예외는numberOfInputs가 1 미만이거나 지원 채널 수를 초과하면 반드시 발생해야 합니다.BaseAudioContext.createChannelMerger(numberOfInputs) 메서드의 인수. 파라미터 타입 Nullable Optional 설명 numberOfInputsunsigned long✘ ✔ 입력 수를 결정합니다. 최대 32까지 지원해야 하며, 지정하지 않으면 6이 사용됩니다.반환 타입:ChannelMergerNode createChannelSplitter(numberOfOutputs)-

팩토리 메서드로,

ChannelSplitterNode를 생성합니다. 채널 분리 기능을 나타냅니다.IndexSizeError예외는numberOfOutputs가 1 미만이거나 지원 채널 수를 초과하면 반드시 발생해야 합니다.BaseAudioContext.createChannelSplitter(numberOfOutputs) 메서드의 인수. 파라미터 타입 Nullable Optional 설명 numberOfOutputsunsigned long✘ ✔ 출력 수를 결정합니다. 최대 32까지 지원해야 하며, 지정하지 않으면 6이 사용됩니다.반환 타입:ChannelSplitterNode createConstantSource()-

팩토리 메서드로,

ConstantSourceNode를 생성합니다.파라미터 없음.반환 타입:ConstantSourceNode createConvolver()-

팩토리 메서드로,

ConvolverNode를 생성합니다.파라미터 없음.반환 타입:ConvolverNode createDelay(maxDelayTime)-

팩토리 메서드로,

DelayNode를 생성합니다. 초기 기본 delay time 값은 0초입니다.BaseAudioContext.createDelay(maxDelayTime) 메서드의 인수. 파라미터 타입 Nullable Optional 설명 maxDelayTimedouble✘ ✔ 딜레이 라인에 허용되는 최대 지연 시간(초)을 지정합니다. 지정된 경우, 반드시 0 초과 3분 미만이어야 하며, 그렇지 않으면 NotSupportedError예외가 발생해야 합니다. 지정하지 않으면1이 사용됩니다.반환 타입:DelayNode createDynamicsCompressor()-

팩토리 메서드로,

DynamicsCompressorNode를 생성합니다.파라미터 없음.반환 타입:DynamicsCompressorNode createGain()-

파라미터 없음.반환 타입:

GainNode createIIRFilter(feedforward, feedback)-

BaseAudioContext.createIIRFilter() 메서드의 인수. 파라미터 타입 Nullable Optional 설명 feedforwardsequence<double>✘ ✘ IIR 필터의 전달 함수(transfer function)에 대한 feedforward(분자) 계수 배열입니다. 이 배열의 최대 길이는 20입니다. 모든 값이 0이면 InvalidStateError예외가 반드시 발생해야 합니다.NotSupportedError예외가 배열 길이가 0이거나 20 초과이면 반드시 발생해야 합니다.feedbacksequence<double>✘ ✘ IIR 필터의 전달 함수(transfer function)에 대한 feedback(분모) 계수 배열입니다. 이 배열의 최대 길이는 20입니다. 첫 번째 요소가 0이면 InvalidStateError예외가 반드시 발생해야 합니다.NotSupportedError예외가 배열 길이가 0이거나 20 초과이면 반드시 발생해야 합니다.반환 타입:IIRFilterNode createOscillator()-

팩토리 메서드로,

OscillatorNode를 생성합니다.파라미터 없음.반환 타입:OscillatorNode createPanner()-

팩토리 메서드로,

PannerNode를 생성합니다.파라미터 없음.반환 타입:PannerNode createPeriodicWave(real, imag, constraints)-

팩토리 메서드로,

PeriodicWave를 생성합니다.이 메서드를 호출할 때, 다음 과정을 실행합니다:-

만약

real과imag의 길이가 다르면,IndexSizeError예외가 반드시 발생해야 합니다. -

o를

PeriodicWaveOptions타입의 새 객체로 만듭니다. -

o의

disableNormalization속성을, 팩토리 메서드에 전달된constraints의disableNormalization값으로 설정합니다. -

이 팩토리 메서드가 호출된

BaseAudioContext와 o를 인수로 하여 새PeriodicWavep를 생성합니다. -

p를 반환합니다.

BaseAudioContext.createPeriodicWave() 메서드의 인수. 파라미터 타입 Nullable Optional 설명 realsequence<float>✘ ✘ 코사인(cosine) 파라미터 시퀀스입니다. 자세한 설명은 real생성자 인수 참조.imagsequence<float>✘ ✘ 사인(sine) 파라미터 시퀀스입니다. 자세한 설명은 imag생성자 인수 참조.constraintsPeriodicWaveConstraints✘ ✔ 지정하지 않으면 웨이브폼이 정규화됩니다. 지정된 경우, constraints값에 따라 웨이브폼이 정규화됩니다.반환 타입:PeriodicWave -

createScriptProcessor(bufferSize, numberOfInputChannels, numberOfOutputChannels)-

팩토리 메서드로,

ScriptProcessorNode를 생성합니다. 이 메서드는 폐지(deprecated)되었으며,AudioWorkletNode로 대체될 예정입니다. 스크립트를 사용해 직접 오디오를 처리할ScriptProcessorNode를 생성합니다.IndexSizeError예외는bufferSize또는numberOfInputChannels또는numberOfOutputChannels값이 유효 범위를 벗어나면 반드시 발생해야 합니다.numberOfInputChannels과numberOfOutputChannels모두 0인 경우는 유효하지 않습니다. 이 경우IndexSizeError예외가 반드시 발생해야 합니다.BaseAudioContext.createScriptProcessor(bufferSize, numberOfInputChannels, numberOfOutputChannels) 메서드의 인수. 파라미터 타입 Nullable Optional 설명 bufferSizeunsigned long✘ ✔ bufferSize파라미터는 샘플 프레임 단위로 버퍼 크기를 결정합니다. 값을 전달하지 않거나 0이면, 구현체가 환경에 맞는 최적의 버퍼 크기를 선택하며, 노드의 전체 수명 동안 일정한 2의 거듭제곱 값이 유지됩니다. 명시적으로 bufferSize 값을 지정할 경우, 반드시 다음 값 중 하나여야 합니다: 256, 512, 1024, 2048, 4096, 8192, 16384. 이 값은audioprocess이벤트가 발생하는 빈도와 호출마다 처리해야 할 샘플 프레임 수를 결정합니다.bufferSize값이 낮을수록 지연(latency)이 낮아집니다. 값이 높으면 오디오 끊김(glitches)을 방지하는 데 필요할 수 있습니다. 구현체가 latency와 오디오 품질을 균형 있게 선택하도록, 명시적으로 버퍼 크기를 지정하지 않는 것이 권장됩니다. 지정 값이 위의 허용 값(2의 거듭제곱)이 아니면,IndexSizeError예외가 반드시 발생해야 합니다.numberOfInputChannelsunsigned long✘ ✔ 이 파라미터는 노드의 입력 채널 수를 결정합니다. 기본값은 2입니다. 최대 32까지 반드시 지원해야 합니다. NotSupportedError채널 수가 지원되지 않을 경우 반드시 발생해야 합니다.numberOfOutputChannelsunsigned long✘ ✔ 이 파라미터는 노드의 출력 채널 수를 결정합니다. 기본값은 2입니다. 최대 32까지 반드시 지원해야 합니다. NotSupportedError채널 수가 지원되지 않을 경우 반드시 발생해야 합니다.반환 타입:ScriptProcessorNode createStereoPanner()-

팩토리 메서드로,

StereoPannerNode를 생성합니다.파라미터 없음.반환 타입:StereoPannerNode createWaveShaper()-

팩토리 메서드로,

WaveShaperNode를 생성합니다. 비선형 왜곡 효과를 나타냅니다.파라미터 없음.반환 타입:WaveShaperNode decodeAudioData(audioData, successCallback, errorCallback)-

ArrayBuffer에 포함된 오디오 파일 데이터를 비동기적으로 디코딩합니다.ArrayBuffer는, 예를 들어XMLHttpRequest의response속성에서responseType을"arraybuffer"로 설정한 뒤 불러올 수 있습니다. 오디오 파일 데이터는audio요소가 지원하는 형식이어야 합니다.decodeAudioData()에 전달된 버퍼는 [mimesniff]에서 설명한 sniffing 방식으로 콘텐츠 타입이 결정됩니다.이 함수는 주로 promise 반환값으로 사용하지만, 콜백 파라미터는 레거시 지원을 위해 제공됩니다.

손상된 파일이 있을 경우 구현체가 저자에게 경고하도록 권장합니다. throw하는 것은 breaking change이므로 불가능합니다.

참고: 압축 오디오 데이터 바이트 스트림이 손상되었더라도 디코딩이 진행될 수 있을 경우, 구현체는 개발자 도구 등으로 저자에게 경고하는 것이 권장됩니다.decodeAudioData가 호출되면, 다음 단계는 반드시 제어 스레드에서 실행되어야 합니다:-

this의 관련 전역 객체의 연관 Document가 완전히 활성화(fully active)가 아니라면, 거부된 promise를 반환하며, "

InvalidStateError"DOMException을 사용합니다. -

promise를 새 Promise로 생성합니다.

-

audioData가 detached라면, 다음 단계 실행:-

promise를

[[pending promises]]에 추가합니다. -

detach 작업을

audioDataArrayBuffer에 대해 실행합니다. 이 작업에서 예외가 발생하면 3단계로 점프. -

디코딩 작업을 다른 스레드에 큐잉합니다.

-

-

그 외에는 다음 에러 단계 실행:

-

error를

DataCloneError로 지정합니다. -

promise를 error로 거부하고,

[[pending promises]]에서 제거합니다. -

미디어 요소 태스크를 큐잉하여

errorCallback을 error와 함께 호출합니다.

-

-

promise를 반환합니다.

디코딩 작업을 다른 스레드에 큐잉할 때는, 반드시 제어 스레드나 렌더링 스레드가 아닌디코딩 스레드(decoding thread)에서 다음 단계가 실행되어야 합니다.참고: 여러

디코딩 스레드(decoding thread)가 병렬로 실행되어decodeAudioData의 여러 호출을 처리할 수 있습니다.-

can decode를 true로 초기화된 불리언 플래그로 둡니다.

-

audioDataMIME 타입을 MIME Sniffing § 6.2 오디오/비디오 타입 패턴 매칭을 사용해 판별 시, 타입 패턴 매칭 알고리즘이undefined를 반환하면, can decode를 false로 설정합니다. -

만약 can decode가 true라면,

audioData를 선형 PCM(linear PCM)으로 디코딩을 시도합니다. 실패 시 can decode를 false로 설정합니다.미디어 바이트 스트림에 여러 오디오 트랙이 있으면, 첫 번째 트랙만 선형 PCM(linear pcm)으로 디코딩합니다.

참고: 디코딩 과정에 더 많은 제어가 필요하다면 [WEBCODECS]를 사용할 수 있습니다.

-

만약 can decode가

false라면, 미디어 요소 태스크를 큐잉해서 다음 단계 실행:-

error는 이름이

EncodingError인DOMException입니다.-

promise를 error로 거부하고,

[[pending promises]]에서 제거합니다.

-

-

errorCallback이 존재하면 error와 함께errorCallback을 호출합니다.

-

-

그 외에는:

-

디코딩된 선형 PCM(linear PCM) 오디오 데이터를 결과로 받아,

BaseAudioContext의 샘플레이트와 다를 경우 샘플레이트 변환을 수행합니다. -

미디어 요소 태스크를 큐잉해서 다음 단계 실행:

-

최종 결과(샘플레이트 변환을 포함할 수 있음)가 담긴

AudioBuffer를 buffer로 지정합니다. -

promise를 buffer로 resolve합니다.

-

successCallback이 존재하면 buffer와 함께successCallback을 호출합니다.

-

-

BaseAudioContext.decodeAudioData() 메서드의 인수. 파라미터 타입 Nullable Optional 설명 audioDataArrayBuffer✘ ✘ 압축된 오디오 데이터가 담긴 ArrayBuffer. successCallbackDecodeSuccessCallback?✔ ✔ 디코딩이 완료되면 호출되는 콜백 함수. 이 콜백의 단일 인수는 디코딩된 PCM 오디오 데이터를 나타내는 AudioBuffer입니다. errorCallbackDecodeErrorCallback?✔ ✔ 오디오 파일 디코딩 에러 발생 시 호출되는 콜백 함수. 반환 타입:Promise<AudioBuffer> -

1.1.3. 콜백 DecodeSuccessCallback()

파라미터

decodedData, 타입AudioBuffer-

디코딩된 오디오 데이터가 담긴 AudioBuffer입니다.

1.1.4. 콜백 DecodeErrorCallback()

파라미터

error, 타입DOMException-

디코딩 중 발생한 오류입니다.

1.1.5. 생명주기

AudioContext가

생성되면,

더 이상 재생할 사운드가 없거나 페이지가 사라질 때까지 계속 소리를 재생합니다.

1.1.6. 인트로스펙션 또는 직렬화 프리미티브의 부재

Web Audio API는 오디오 소스 스케줄링에 fire-and-forget 방식을 취합니다. 즉, 소스 노드는 AudioContext의

생명주기 동안 각 노트마다 생성되고, 그래프에서 명시적으로 제거되지 않습니다. 이는 직렬화 API와 호환되지 않으며, 직렬화할 수 있는 안정적인 노드 집합이 존재하지 않기 때문입니다.

또한, 인트로스펙션 API가 있으면 콘텐츠 스크립트가 가비지 컬렉션(GC)을 관찰할 수 있게 됩니다.

1.1.7. BaseAudioContext

하위 클래스와 연관된 시스템 리소스

AudioContext와

OfflineAudioContext

하위 클래스는 리소스 소모가 큰 객체로 간주해야 합니다. 이러한 객체를 생성하면, 우선순위가 높은 스레드를 생성하거나 저지연 시스템 오디오 스트림을 사용할 수 있으며, 둘 다 에너지 소비에

영향을 줄 수 있습니다. 보통 하나의 문서에 AudioContext를

여러 개 생성할 필요는 없습니다.

BaseAudioContext

하위 클래스를 생성하거나 다시 시작(resume)하면 해당 컨텍스트에 시스템 리소스 할당이 필요합니다. AudioContext의

경우, 시스템 오디오 스트림 생성도 필요합니다. 이러한 작업은 컨텍스트가 연결된 오디오 그래프에서 출력을 생성하기 시작하면 완료됩니다.

또한, user-agent는 구현에 따라 AudioContext의

최대 개수를 정의할 수 있으며,

최대 개수 초과 시 새로운 AudioContext를

생성하려고 하면 NotSupportedError가

발생합니다.

suspend와

close는

저자가 시스템 리소스(스레드, 프로세스, 오디오 스트림 등)를 해제할 수 있게 해줍니다. BaseAudioContext를

일시정지(suspend)하면 일부 리소스를 해제할 수 있으며, resume을

호출해 나중에 다시 동작할 수 있습니다.

AudioContext를

닫으면 모든 리소스가 해제되어, 더 이상 사용할 수 없으며 다시 시작(resume)할 수 없습니다.

참고: 예를 들어, 오디오 콜백이 정기적으로 실행되기를 기다리거나, 하드웨어가 처리 준비될 때까지 대기해야 할 수도 있습니다.

1.2. AudioContext

인터페이스

이 인터페이스는 AudioDestinationNode가

실시간 출력 장치에 라우팅되어 사용자에게 신호를 전달하는 오디오 그래프를 나타냅니다. 대부분의 사용 사례에서는 문서당 하나의 AudioContext만

사용합니다.

enum {AudioContextLatencyCategory "balanced" ,"interactive" ,"playback" };

| 열거값 | 설명 |

|---|---|

"balanced"

| 오디오 출력 지연(latency)과 전력 소비를 균형 있게 조절합니다. |

"interactive"

| 끊김 없이 가능한 가장 낮은 오디오 출력 지연(latency)을 제공합니다. 기본값입니다. |

"playback"

| 오디오 출력 지연보다 지속적인 재생과 중단 없는 플레이백을 우선시합니다. 전력 소비가 가장 낮습니다. |

enum {AudioSinkType "none" };

| 열거값 | 설명 |

|---|---|

"none"

| 오디오 그래프가 오디오 출력 장치를 통해 재생되지 않고 처리됩니다. |

[Exposed =Window ]interface AudioContext :BaseAudioContext {constructor (optional AudioContextOptions contextOptions = {});readonly attribute double baseLatency ;readonly attribute double outputLatency ; [SecureContext ]readonly attribute (DOMString or AudioSinkInfo )sinkId ; [SecureContext ]readonly attribute AudioRenderCapacity renderCapacity ;attribute EventHandler onsinkchange ;attribute EventHandler onerror ;AudioTimestamp getOutputTimestamp ();Promise <undefined >resume ();Promise <undefined >suspend ();Promise <undefined >close (); [SecureContext ]Promise <undefined >((setSinkId DOMString or AudioSinkOptions ));sinkId MediaElementAudioSourceNode createMediaElementSource (HTMLMediaElement );mediaElement MediaStreamAudioSourceNode createMediaStreamSource (MediaStream );mediaStream MediaStreamTrackAudioSourceNode createMediaStreamTrackSource (MediaStreamTrack );mediaStreamTrack MediaStreamAudioDestinationNode createMediaStreamDestination (); };

AudioContext가

시작 가능(allowed to

start)하다고 하는 것은 user agent가 컨텍스트 상태를 "suspended"

에서

"running"으로

전환하는 것을 허용하는 경우를 의미합니다.

User agent는 이 초기 전환을 허용하지 않을 수 있으며,

AudioContext의

관련 전역 객체(relevant global object)가 sticky activation 상태일 때만 허용할 수 있습니다.

AudioContext에는

다음과 같은 내부 슬롯이 있습니다:

[[suspended by user]]-

컨텍스트가 사용자 코드에 의해 일시정지되었는지를 나타내는 boolean 플래그입니다. 초기값은

false입니다. [[sink ID]]-

현재 오디오 출력 장치의 식별자 또는 정보를 각각 나타내는

DOMString또는AudioSinkInfo입니다. 초기값은""이며, 이는 기본 오디오 출력 장치를 의미합니다. [[pending resume promises]]-

Promise를resume()호출로 생성한 대기 중인 순서 리스트로 저장합니다. 초기값은 빈 리스트입니다.

1.2.1. 생성자

AudioContext(contextOptions)-

현재 설정 객체의 관련 전역 객체의 연결된 Document가 완전히 활성화(fully active)가 아니면, "

InvalidStateError" 예외를 발생시키고, 이 단계들을 중단합니다.AudioContext를 생성할 때, 다음 단계를 실행합니다:-

context를 새

AudioContext객체로 만듭니다. -

[[control thread state]]를 context에서suspended로 설정합니다. -

[[rendering thread state]]를 context에서suspended로 설정합니다. -

messageChannel을 새

MessageChannel로 만듭니다. -

controlSidePort를 messageChannel의

port1의 값으로 설정합니다. -

renderingSidePort를 messageChannel의

port2의 값으로 설정합니다. -

serializedRenderingSidePort를 StructuredSerializeWithTransfer(renderingSidePort, « renderingSidePort »)의 결과로 설정합니다.

-

이

audioWorklet의port를 controlSidePort로 설정합니다. -

제어 메시지 큐잉를 통해 AudioContextGlobalScope에 MessagePort 설정을 serializedRenderingSidePort로 실행합니다.

-

contextOptions가 주어진 경우, 다음 하위 단계를 수행합니다:-

sinkId가 지정된 경우, sinkId를contextOptions.의 값으로 두고, 다음 하위 단계 실행:sinkId-

sinkId와

[[sink ID]]가 모두DOMString타입이고, 서로 같다면 이 하위 단계를 중단합니다. -

sinkId가

AudioSinkOptions타입이고,[[sink ID]]가AudioSinkInfo타입이며, sinkId의type과type이 같다면 이 하위 단계를 중단합니다. -

validationResult를 sink identifier validation 의 반환값으로 설정합니다.

-

validationResult가

DOMException타입이면, 해당 예외를 발생시키고 이 하위 단계를 중단합니다. -

sinkId가

DOMString타입이면,[[sink ID]]를 sinkId로 설정하고 이 하위 단계를 중단합니다. -

sinkId가

AudioSinkOptions타입이면,[[sink ID]]를 sinkId의type값으로 생성한 새AudioSinkInfo인스턴스로 설정합니다.

-

-

내부 latency를

contextOptions.값에 따라 설정합니다. 상세 내용은latencyHintlatencyHint참조. -

contextOptions.가 지정된 경우, context의sampleRatesampleRate를 해당 값으로 설정합니다. 그렇지 않으면 다음 하위 단계 실행:-

sinkId가 빈 문자열이거나

AudioSinkOptions타입이면, 기본 출력 장치의 샘플레이트를 사용합니다. 이 하위 단계를 중단합니다. -

sinkId가

DOMString타입이면, 해당 sinkId가 식별하는 출력 장치의 샘플레이트를 사용합니다. 이 하위 단계를 중단합니다.

contextOptions.가 출력 장치의 샘플레이트와 다르면, user agent는 반드시 오디오 출력을 출력 장치의 샘플레이트와 맞도록 리샘플링해야 합니다.sampleRate참고: 리샘플링이 필요하면 context의 latency에 큰 영향이 있을 수 있습니다.

-

-

-

context를 반환합니다.

처리를 시작하라는 제어 메시지를 전송하는 것은 다음 단계를 실행하는 것을 의미합니다:-

document를 현재 설정 객체의 관련 전역 객체의 연결된 Document로 설정합니다.

-

[[sink ID]]를 기반으로, 렌더링에 사용할 오디오 출력 장치를 위한 시스템 리소스 할당을 시도합니다:-

빈 문자열일 경우 기본 오디오 출력 장치.

-

[[sink ID]]가 식별하는 오디오 출력 장치.

-

리소스 할당에 실패하면, 다음 단계 실행:

-

document가

"speaker-selection"으로 식별되는 기능을 사용할 수 없으면, 이 하위 단계 중단. -

미디어 요소 태스크 큐잉을 통해

error이벤트를AudioContext에 발생시키고, 이후 단계 중단.

-

-

-

this

[[rendering thread state]]를running으로 설정합니다. 대상AudioContext입니다. -

미디어 요소 태스크 큐잉을 통해 다음 단계 실행:

-

state속성을AudioContext에서 "running"으로 설정합니다. -

statechange 이벤트를

AudioContext에 발생시킵니다.

-

참고:

AudioContext가 인수 없이 생성되고 리소스 할당에 실패하는 경우, User-Agent는 오디오 출력 장치를 에뮬레이션하는 메커니즘을 사용하여 오디오 그래프를 조용히 렌더링 시도할 수 있습니다.제어 메시지를 통해MessagePort를AudioWorkletGlobalScope에 설정하는 것은, 렌더링 스레드에서, 전달된 serializedRenderingSidePort로 다음 단계를 실행하는 것을 의미합니다:-

deserializedPort를 StructuredDeserialize(serializedRenderingSidePort, 현재 Realm)의 결과로 설정합니다.

-

port를 deserializedPort로 설정합니다.

AudioContext.constructor(contextOptions) 메서드의 인수. 파라미터 타입 Nullable Optional 설명 contextOptionsAudioContextOptions✘ ✔ AudioContext생성 방식을 제어하는 사용자 지정 옵션입니다. -

1.2.2. 속성

baseLatency, 타입 double, 읽기 전용-

이 값은

AudioContext가AudioDestinationNode에서 오디오를 오디오 서브시스템으로 전달할 때 소모되는 처리 지연(초)을 나타냅니다.AudioDestinationNode의 출력과 오디오 하드웨어 사이의 추가 처리, 또는 오디오 그래프 자체에서 발생하는 지연은 포함되지 않습니다.예시로, 오디오 컨텍스트가 44.1 kHz에서 기본 렌더 퀀텀 크기로 실행되고,

AudioDestinationNode가 내부적으로 더블 버퍼링을 구현하여 각 렌더 퀀텀마다 오디오를 처리 및 출력할 수 있다면, 처리 지연은 \((2\cdot128)/44100 = 5.805 \mathrm{ ms}\) 정도입니다. outputLatency, 타입 double, 읽기 전용-

오디오 출력 지연의 초 단위 추정값입니다. 즉, UA가 호스트 시스템에 버퍼 재생을 요청한 시점과, 버퍼의 첫 샘플이 실제 오디오 출력 장치에서 처리되는 시점 사이의 간격입니다. 스피커나 헤드폰처럼 음향 신호를 생성하는 장치의 경우, 이 시점은 샘플의 소리가 실제로 발생하는 시점을 의미합니다.

outputLatency속성 값은 플랫폼 및 연결된 오디오 출력 장치 하드웨어에 따라 달라집니다.outputLatency값은 컨텍스트가 실행 중이거나 연결된 오디오 출력 장치가 변경될 때 변할 수 있습니다. 정확한 동기화가 필요할 때 이 값을 자주 쿼리하는 것이 좋습니다. renderCapacity, 타입 AudioRenderCapacity, 읽기 전용-

이 속성은

AudioContext와 연관된AudioRenderCapacity인스턴스를 반환합니다. sinkId, 타입(DOMString or AudioSinkInfo), 읽기 전용-

이 속성은

[[sink ID]]내부 슬롯의 값을 반환합니다. 이 속성은 업데이트 시 캐시되며, 캐싱 후에는 동일한 객체를 반환합니다. onsinkchange, 타입 EventHandler-

setSinkId()에서 발생하는 이벤트 핸들러입니다. 이 핸들러의 이벤트 타입은sinkchange입니다. 출력 장치 변경이 완료되면 이 이벤트가 디스패치됩니다.참고:

AudioContext생성 시 초기 장치 선택에는 이 이벤트가 발생하지 않습니다. 초기 출력 장치 준비 여부는statechange이벤트로 확인할 수 있습니다. onerror, 타입 EventHandler-

Event가AudioContext에서 디스패치될 때 사용하는 이벤트 핸들러입니다. 이 핸들러의 이벤트 타입은error이며, user agent가 다음과 같은 경우에 이벤트를 디스패치할 수 있습니다:-

선택한 오디오 장치 초기화 및 활성화에 실패한 경우

-

AudioContext와 연결된 오디오 출력 장치가 컨텍스트가running상태일 때 분리된 경우 -

운영체제에서 오디오 장치 오류가 보고된 경우

-

1.2.3. 메서드

close()-

AudioContext를 닫고, 사용 중인 시스템 리소스를 해제합니다. 이는AudioContext가 생성한 모든 객체를 자동으로 해제하지는 않지만,AudioContext의currentTime진행을 일시정지하고, 오디오 데이터 처리를 중단합니다.close가 호출되면, 다음 단계를 실행합니다:-

this의 관련 전역 객체의 연결된 Document가 완전히 활성화 상태가 아니면, "

InvalidStateError"DOMException으로 거부된 promise를 반환합니다. -

promise를 새 Promise로 둡니다.

-

AudioContext의[[control thread state]]플래그가closed라면 해당 promise를InvalidStateError로 거부하고, 이 단계를 중단하며 promise를 반환합니다. -

AudioContext의[[control thread state]]플래그를closed로 설정합니다. -

제어 메시지를 큐잉하여

AudioContext를 닫습니다. -

promise를 반환합니다.

제어 메시지를 실행하여AudioContext를 닫는다는 것은 렌더링 스레드에서 다음 단계를 수행하는 것을 의미합니다:-

시스템 리소스 해제를 시도합니다.

-

[[rendering thread state]]를suspended로 설정합니다.이는 렌더링을 중단합니다. -

이 제어 메시지가 문서 언로드에 대한 반응으로 실행되는 경우, 이 알고리즘을 중단합니다.

이 경우에는 제어 스레드에 알릴 필요가 없습니다. -

미디어 요소 태스크를 큐잉하여 다음 단계를 실행합니다:

-

promise를 resolve합니다.

-

AudioContext의state속성이 이미 "closed"가 아니라면:-

AudioContext의state속성을 "closed"로 설정합니다. -

미디어 요소 태스크를 큐잉하여 statechange라는 이름의 이벤트를

AudioContext에 발생시킵니다.

-

-

AudioContext가 닫히면, 해당MediaStream과HTMLMediaElement에 연결되어 있던 출력은 무시됩니다. 즉, 더 이상 스피커나 기타 출력 장치로의 출력이 발생하지 않습니다. 동작의 유연성이 더 필요하다면HTMLMediaElement.captureStream()사용을 고려하세요.Note:

AudioContext가 닫히면, 구현체는 일시정지(suspend)할 때보다 더 적극적으로 리소스를 해제하도록 선택할 수 있습니다.파라미터 없음. -

createMediaElementSource(mediaElement)-

MediaElementAudioSourceNode를 지정된HTMLMediaElement로부터 생성합니다. 이 메서드를 호출하면HTMLMediaElement의 오디오 재생은AudioContext의 처리 그래프로 재라우팅됩니다.AudioContext.createMediaElementSource() 메서드의 인수. 파라미터 타입 Nullable Optional 설명 mediaElementHTMLMediaElement✘ ✘ 재라우팅될 미디어 요소. 반환 타입:MediaElementAudioSourceNode createMediaStreamDestination()-

MediaStreamAudioDestinationNode를 생성합니다.파라미터 없음. createMediaStreamSource(mediaStream)-

MediaStreamAudioSourceNode를 생성합니다.AudioContext.createMediaStreamSource() 메서드의 인수. 파라미터 타입 Nullable Optional 설명 mediaStreamMediaStream✘ ✘ 소스로 동작할 미디어 스트림. 반환 타입:MediaStreamAudioSourceNode createMediaStreamTrackSource(mediaStreamTrack)-

MediaStreamTrackAudioSourceNode를 생성합니다.AudioContext.createMediaStreamTrackSource() 메서드의 인수. 파라미터 타입 Nullable Optional 설명 mediaStreamTrackMediaStreamTrack✘ ✘ 소스로 동작할 MediaStreamTrack. 이 객체의kind속성 값은"audio"와 같아야 하며, 그렇지 않으면InvalidStateError예외가 반드시 발생해야 합니다. getOutputTimestamp()-

컨텍스트에 대해 서로 관련된 두 오디오 스트림 위치 값을 담는 새

AudioTimestamp인스턴스를 반환합니다:contextTime멤버는 오디오 출력 장치에 의해 현재 렌더링 중인 샘플 프레임의 시간을 포함하며(즉, 출력 오디오 스트림 위치), 컨텍스트의currentTime과 동일한 단위와 기준점을 갖습니다.performanceTime멤버는 저장된contextTime값에 해당하는 샘플 프레임이 오디오 출력 장치에 의해 렌더링된 시점을 추정한 시간을 포함하며, [hr-time-3]에 설명된performance.now()와 동일한 단위와 기준점을 갖습니다.컨텍스트의 렌더링 그래프가 아직 오디오 블록을 처리하지 않았다면,

getOutputTimestamp호출은 두 멤버가 모두 0을 포함하는AudioTimestamp인스턴스를 반환합니다.컨텍스트의 렌더링 그래프가 오디오 블록 처리를 시작한 이후에는,

currentTime속성 값이 항상contextTime값보다 큽니다. 이getOutputTimestamp메서드 호출에서 얻은 값과 비교했을 때 그렇습니다.getOutputTimestamp메서드에서 반환된 값을 사용하여, 약간 이후의 컨텍스트 시간 값에 대한 퍼포먼스 시간 추정을 얻을 수 있습니다:function outputPerformanceTime( contextTime) { const timestamp= context. getOutputTimestamp(); const elapsedTime= contextTime- timestamp. contextTime; return timestamp. performanceTime+ elapsedTime* 1000 ; } 위 예시에서 추정의 정확도는 인수 값이 현재 출력 오디오 스트림 위치에 얼마나 가까운지에 달려 있습니다. 즉, 전달된

contextTime이timestamp.contextTime에 가까울수록 얻은 추정의 정확도는 더 좋아집니다.Note: 컨텍스트의

currentTime과contextTime(getOutputTimestamp호출로 얻은 값) 간의 차이는 신뢰할 수 있는 출력 지연 추정으로 간주될 수 없습니다. 그 이유는currentTime이 일정하지 않은 시간 간격으로 증가할 수 있기 때문입니다. 대신outputLatency속성을 사용해야 합니다.파라미터 없음.반환 타입:AudioTimestamp resume()-

일시정지된 경우

AudioContext의currentTime진행을 재개합니다.resume이 호출되면, 다음 단계를 실행합니다:-

this의 관련 전역 객체의 연결된 Document가 완전히 활성화 상태가 아니면, "

InvalidStateError"DOMException으로 거부된 promise를 반환합니다. -

promise를 새 Promise로 둡니다.

-

AudioContext의[[control thread state]]가closed라면 해당 promise를InvalidStateError로 거부하고, 이 단계를 중단하며 promise를 반환합니다. -

[[suspended by user]]를false로 설정합니다. -

컨텍스트가 시작 가능하지 않다면, promise를

[[pending promises]]와[[pending resume promises]]에 추가하고, 이 단계를 중단하며 promise를 반환합니다. -

AudioContext의[[control thread state]]를running으로 설정합니다. -

제어 메시지를 큐잉하여

AudioContext를 재개합니다. -

promise를 반환합니다.

제어 메시지를 실행하여AudioContext를 재개한다는 것은 렌더링 스레드에서 다음 단계를 수행하는 것을 의미합니다:-

시스템 리소스 확보를 시도합니다.

-

AudioContext의[[rendering thread state]]를running으로 설정합니다. -

오디오 그래프 렌더링을 시작합니다.

-

실패한 경우, 미디어 요소 태스크를 큐잉하여 다음 단계를 실행합니다:

-

[[pending resume promises]]의 모든 promise를 순서대로 거부하고, 이어서[[pending resume promises]]를 비웁니다. -

추가로, 해당 promise들을

[[pending promises]]에서 제거합니다.

-

-

미디어 요소 태스크를 큐잉하여 다음 단계를 실행합니다:

-

[[pending resume promises]]의 모든 promise를 순서대로 resolve합니다. -

[[pending resume promises]]를 비우고, 또한 해당 promise들을[[pending promises]]에서 제거합니다. -

promise를 resolve합니다.

-

AudioContext의state속성이 이미 "running"이 아니라면:-

AudioContext의state속성을 "running"으로 설정합니다. -

미디어 요소 태스크를 큐잉하여 statechange라는 이름의 이벤트를

AudioContext에 발생시킵니다.

-

-

파라미터 없음. -

suspend()-

AudioContext의currentTime진행을 일시정지합니다. 이미 처리된 현재 컨텍스트 처리 블록이 목적지로 재생되도록 허용한 다음, 시스템이 오디오 하드웨어에 대한 점유를 해제할 수 있도록 합니다. 이는 애플리케이션이 일정 시간 동안AudioContext가 필요하지 않음을 알고, 해당AudioContext와 연결된 시스템 리소스를 일시적으로 해제하려고 할 때 일반적으로 유용합니다. 프레임 버퍼가 비어(하드웨어에 전달 완료) 있으면 promise가 resolve되며, 컨텍스트가 이미suspended라면 즉시(다른 효과 없이) resolve됩니다. 컨텍스트가 닫혀 있으면 promise는 거부됩니다.suspend가 호출되면, 다음 단계를 실행합니다:-

this의 관련 전역 객체의 연결된 Document가 완전히 활성화 상태가 아니면, "

InvalidStateError"DOMException으로 거부된 promise를 반환합니다. -

promise를 새 Promise로 둡니다.

-

AudioContext의[[control thread state]]가closed라면 해당 promise를InvalidStateError로 거부하고, 이 단계를 중단하며 promise를 반환합니다. -

promise를

[[pending promises]]에 추가합니다. -

[[suspended by user]]를true로 설정합니다. -

AudioContext의[[control thread state]]를suspended로 설정합니다. -

제어 메시지를 큐잉하여

AudioContext를 일시정지합니다. -

promise를 반환합니다.

제어 메시지를 실행하여AudioContext를 일시정지한다는 것은 렌더링 스레드에서 다음 단계를 수행하는 것을 의미합니다:-

시스템 리소스 해제를 시도합니다.

-

AudioContext의[[rendering thread state]]를suspended로 설정합니다. -

미디어 요소 태스크를 큐잉하여 다음 단계를 실행합니다:

-

promise를 resolve합니다.

-

AudioContext의state속성이 이미 "suspended"가 아니라면:-

AudioContext의state속성을 "suspended"로 설정합니다. -

미디어 요소 태스크를 큐잉하여 statechange라는 이름의 이벤트를

AudioContext에 발생시킵니다.

-

-

AudioContext가 일시정지된 동안에는,MediaStream의 출력이 무시되며(실시간 스트림의 특성상 데이터가 손실됨),HTMLMediaElement도 시스템이 재개될 때까지 마찬가지로 출력이 무시됩니다.AudioWorkletNode와ScriptProcessorNode의 처리 핸들러는 일시정지 중 호출되지 않지만, 컨텍스트가 재개되면 다시 호출됩니다.AnalyserNode의 윈도 함수 목적상 데이터는 연속 스트림으로 간주됩니다. 즉,resume()/suspend()는AnalyserNode의 데이터 스트림에 무음을 삽입하지 않습니다. 특히,AudioContext가 일시정지된 동안AnalyserNode함수를 반복적으로 호출하면 동일한 데이터가 반환되어야 합니다.파라미터 없음. -

setSinkId((DOMString or AudioSinkOptions) sinkId)-

출력 장치의 식별자를 설정합니다. 이 메서드가 호출되면, 사용자 에이전트는 다음 단계를 수행해야 합니다:

-

sinkId를 메서드의 첫 번째 인수로 둡니다.

-

sinkId가

[[sink ID]]와 같다면, promise를 반환하고 즉시 resolve한 뒤 이 단계를 중단합니다. -

validationResult를 sink 식별자 검증의 반환 값으로 둡니다 (sinkId에 대해).

-

validationResult가

null이 아니면, validationResult로 거부된 promise를 반환하고 이 단계를 중단합니다. -

p를 새 promise로 둡니다.

-

p와 sinkId를 포함한 제어 메시지를 전송하여 처리를 시작합니다.

-

p를 반환합니다.

setSinkId()중 처리를 시작하기 위해 제어 메시지를 전송한다는 것은 다음 단계를 수행하는 것을 의미합니다:-

이 알고리즘에 전달된 promise를 p로 둡니다.

-

이 알고리즘에 전달된 sink 식별자를 sinkId로 둡니다.

-

sinkId와

[[sink ID]]가 모두DOMString타입이고 서로 같다면, 미디어 요소 태스크를 큐잉하여 p를 resolve하고 이 단계를 중단합니다. -

sinkId가

AudioSinkOptions타입이고,[[sink ID]]가AudioSinkInfo타입이며, sinkId의type과type이 서로 같다면, 미디어 요소 태스크를 큐잉하여 p를 resolve하고 이 단계를 중단합니다. -

wasRunning을 true로 둡니다.

-

AudioContext의[[rendering thread state]]가"suspended"이면 wasRunning을 false로 설정합니다. -

현재 렌더 퀀텀을 처리한 뒤 렌더러를 일시정지합니다.

-

시스템 리소스 해제를 시도합니다.

-

wasRunning이 true라면:

-

AudioContext의[[rendering thread state]]를"suspended"로 설정합니다. -

미디어 요소 태스크를 큐잉하여 다음 단계를 실행합니다:

-

AudioContext의state속성이 이미 "suspended"가 아니라면:-

AudioContext의state속성을 "suspended"로 설정합니다. -

statechange라는 이름의 이벤트를 연결된

AudioContext에 발생시킵니다.

-

-

-

-

[[sink ID]]에 기반하여 렌더링에 사용할 다음 오디오 출력 장치를 위해 시스템 리소스 확보를 시도합니다:-

빈 문자열의 경우 기본 오디오 출력 장치.

-

[[sink ID]]로 식별되는 오디오 출력 장치.

실패한 경우, "

InvalidAccessError"로 p를 거부하고 이후 단계를 중단합니다. -

-

미디어 요소 태스크를 큐잉하여 다음 단계를 실행합니다:

-

sinkId가

DOMString타입이면,[[sink ID]]를 sinkId로 설정하고 이 단계를 중단합니다. -

sinkId가

AudioSinkOptions타입이고[[sink ID]]가DOMString타입이면,[[sink ID]]를 sinkId의type값으로 생성한 새AudioSinkInfo인스턴스로 설정합니다. -

sinkId가

AudioSinkOptions타입이고[[sink ID]]가AudioSinkInfo타입이면,type을[[sink ID]]의 sinkId의type값으로 설정합니다. -

p를 resolve합니다.

-

sinkchange라는 이름의 이벤트를 연결된

AudioContext에 발생시킵니다.

-

-

wasRunning이 true라면:

-

AudioContext의[[rendering thread state]]를"running"으로 설정합니다. -

미디어 요소 태스크를 큐잉하여 다음 단계를 실행합니다:

-

AudioContext의state속성이 이미 "running"이 아니라면:-

AudioContext의state속성을 "running"으로 설정합니다. -

statechange라는 이름의 이벤트를 연결된

AudioContext에 발생시킵니다.

-

-

-

-

1.2.4.

sinkId

유효성 검사

이 알고리즘은 sinkId를

수정하기 위해 제공된 정보를 검증하는 데 사용됩니다:

-

document를 현재 설정 객체의 연결된 Document로 둡니다.

-

sinkIdArg를 이 알고리즘에 전달된 값으로 둡니다.

-

document가

"speaker-selection"로 식별된 기능을 사용할 수 없다면, 이름이 "NotAllowedError"인 새DOMException을 반환합니다. -

sinkIdArg가

DOMString타입이지만 빈 문자열이 아니거나enumerateDevices()에서 반환되는 오디오 출력 장치와 일치하지 않으면, 이름이 "NotFoundError"인 새DOMException을 반환합니다. -

null을 반환합니다.

1.2.5. AudioContextOptions

AudioContextOptions

딕셔너리는 AudioContext에

사용자 지정 옵션을 지정하는 데 사용됩니다.

dictionary AudioContextOptions { (AudioContextLatencyCategory or double )latencyHint = "interactive";float sampleRate ; (DOMString or AudioSinkOptions )sinkId ; (AudioContextRenderSizeCategory or unsigned long )renderSizeHint = "default"; };

1.2.5.1. 딕셔너리 AudioContextOptions

멤버

latencyHint, 타입(AudioContextLatencyCategory or double), 기본값은"interactive"-

오디오 출력 지연(latency)과 전력 소비 간의 트레이드오프에 영향을 주는 재생 유형을 지정합니다.

latencyHint의 권장 값은AudioContextLatencyCategory중 하나입니다. 하지만, 더 세밀하게 latency와 전력 소비의 균형을 제어하기 위해 초 단위의 double 값을 지정할 수도 있습니다. 브라우저는 해당 값을 적절히 해석할 수 있습니다. 실제로 적용되는 지연값은 AudioContext의baseLatency속성에서 확인할 수 있습니다. sampleRate, 타입 float-

생성될

AudioContext의sampleRate를 이 값으로 설정합니다. 지원되는 값은AudioBuffer의 샘플레이트와 동일합니다. 지정한 샘플레이트가 지원되지 않을 경우NotSupportedError예외가 반드시 발생해야 합니다.sampleRate가 지정되지 않은 경우, 해당AudioContext에 대해 출력 장치의 권장 샘플레이트가 사용됩니다. sinkId, 타입(DOMString or AudioSinkOptions)-

오디오 출력 장치의 식별자 또는 관련 정보입니다. 자세한 내용은

sinkId를 참조하세요. renderSizeHint, 타입(AudioContextRenderSizeCategory or unsigned long), 기본값은"default"-

정수값을 전달하면 특정 렌더 퀀텀 크기를 요청할 수 있고, 아무 값도 전달하지 않거나

"default"를 지정하면 128 프레임의 기본값을 사용합니다."hardware"를 지정하면 User-Agent가 적합한 렌더 퀀텀 크기를 선택하도록 요청할 수 있습니다.이 값은 힌트이며 반드시 반영되는 것은 아닙니다.

1.2.6.

AudioSinkOptions

AudioSinkOptions

딕셔너리는 sinkId에

대한 옵션을 지정하는 데 사용됩니다.

dictionary AudioSinkOptions {required AudioSinkType type ; };

1.2.6.1. 딕셔너리 AudioSinkOptions

멤버

type, 타입 AudioSinkType-

장치의 타입을 지정하기 위한

AudioSinkType값입니다.

1.2.7. AudioSinkInfo

AudioSinkInfo

인터페이스는 sinkId를

통해 현재 오디오 출력 장치의 정보를 얻는 데 사용됩니다.

[Exposed =Window ]interface AudioSinkInfo {readonly attribute AudioSinkType type ; };

1.2.7.1. 속성

type, 타입 AudioSinkType, 읽기 전용-

장치의 타입을 나타내는

AudioSinkType값입니다.

1.2.8. AudioTimestamp

dictionary AudioTimestamp {double contextTime ;DOMHighResTimeStamp performanceTime ; };

1.2.8.1. 딕셔너리 AudioTimestamp

멤버

contextTime, 타입 double-

BaseAudioContext의

currentTime시간 좌표계의 한 지점을 나타냅니다. performanceTime, 타입 DOMHighResTimeStamp-

[hr-time-3]에서 설명한

Performance인터페이스의 시간 좌표계의 한 지점을 나타냅니다.

1.2.9. AudioRenderCapacity

[Exposed =Window ]interface :AudioRenderCapacity EventTarget {undefined start (optional AudioRenderCapacityOptions = {});options undefined stop ();attribute EventHandler onupdate ; };

이 인터페이스는 AudioContext의

렌더링 성능 지표를 제공합니다.

이를 계산하기 위해 렌더러는 load value를 시스템 레벨

오디오 콜백마다 수집합니다.

1.2.9.1. 속성

onupdate, 타입 EventHandler-

이 이벤트 핸들러의 이벤트 타입은

update입니다. 이벤트는AudioRenderCapacityEvent인터페이스를 사용하여 디스패치됩니다.

1.2.9.2. 메서드

start(options)-

메트릭 수집 및 분석을 시작합니다. 이는 주기적으로 update라는 이벤트를

update이름으로AudioRenderCapacity에서,AudioRenderCapacityEvent를 사용하여,AudioRenderCapacityOptions에 지정된 업데이트 간격으로 발생시킵니다. stop()-

메트릭 수집 및 분석을 중단합니다. 또한

update이벤트의 디스패치를 중단합니다.

1.2.10.

AudioRenderCapacityOptions

AudioRenderCapacityOptions

딕셔너리는 AudioRenderCapacity에

대한 사용자 옵션을 제공하는 데 사용할 수 있습니다.

dictionary {AudioRenderCapacityOptions double updateInterval = 1; };

1.2.10.1. 딕셔너리 AudioRenderCapacityOptions

멤버

updateInterval, 타입 double, 기본값1-

AudioRenderCapacityEvent디스패치를 위한 갱신 간격(초 단위)입니다. load value는 시스템 레벨 오디오 콜백마다 계산되며, 지정된 간격 동안 여러 load value가 수집됩니다. 예를 들어, 렌더러가 48Khz 샘플레이트로 실행되고 시스템 레벨 오디오 콜백의 버퍼 크기가 192 프레임이면, 1초 간격 동안 250개의 load value가 수집됩니다.주어진 값이 시스템 레벨 오디오 콜백의 지속 시간보다 작으면,

NotSupportedError예외가 발생합니다.

1.2.11. AudioRenderCapacityEvent

[Exposed =Window ]interface :AudioRenderCapacityEvent Event {(constructor DOMString ,type optional AudioRenderCapacityEventInit = {});eventInitDict readonly attribute double timestamp ;readonly attribute double averageLoad ;readonly attribute double peakLoad ;readonly attribute double underrunRatio ; };dictionary :AudioRenderCapacityEventInit EventInit {double = 0;timestamp double = 0;averageLoad double = 0;peakLoad double = 0; };underrunRatio

1.2.11.1. 속성

timestamp, 타입 double, 읽기 전용-

데이터 수집 기간의 시작 시점을 연결된

AudioContext의currentTime기준으로 나타냅니다. averageLoad, 타입 double, 읽기 전용-

지정된 갱신 간격 동안 수집된 load 값들의 평균입니다. 정밀도는 1/100까지 제한됩니다.

peakLoad, 타입 double, 읽기 전용-

지정된 갱신 간격 동안 수집된 load 값들 중 최대값입니다. 정밀도 역시 1/100까지 제한됩니다.

underrunRatio, 타입 double, 읽기 전용-

지정된 갱신 간격 동안 load value가 1.0을 초과하는 버퍼 언더런 횟수와 전체 시스템 레벨 오디오 콜백 횟수의 비율입니다.

여기서 \(u\)는 버퍼 언더런 횟수이고 \(N\)은 해당 간격 동안의 시스템 레벨 오디오 콜백 횟수입니다. 버퍼 언더런 비율은 다음과 같습니다:

-

\(u\) = 0이면 0.0입니다.

-

그 밖의 경우 \(u/N\)을 계산하고, 가장 가까운 100분위로 올림(ceiling) 값을 사용합니다.

-

1.3. OfflineAudioContext

인터페이스

OfflineAudioContext

는 렌더링/믹스다운을 (실시간보다) 더 빠르게 처리할 수 있는 BaseAudioContext의

특수한 타입입니다.

오디오 하드웨어에 렌더링하지 않고, 가능한 한 빠르게 렌더링하며, 렌더링 결과를 AudioBuffer로

반환된 promise를 통해 제공합니다.

[Exposed =Window ]interface OfflineAudioContext :BaseAudioContext {constructor (OfflineAudioContextOptions contextOptions );constructor (unsigned long numberOfChannels ,unsigned long length ,float sampleRate );Promise <AudioBuffer >startRendering ();Promise <undefined >resume ();Promise <undefined >suspend (double );suspendTime readonly attribute unsigned long length ;attribute EventHandler oncomplete ; };

1.3.1. 생성자

OfflineAudioContext(contextOptions)-

현재 설정 객체의 관련 전역 객체의 연결된 Document가 완전히 활성화가 아니면,

c를 새InvalidStateError예외를 발생시키고, 이 단계를 중단합니다.OfflineAudioContext객체로 두고, 다음과 같이 초기화합니다:-

c의

[[control thread state]]를"suspended"로 설정합니다. -

c의

[[rendering thread state]]를"suspended"로 설정합니다. -

이

OfflineAudioContext의[[render quantum size]]를renderSizeHint값에 따라 결정합니다:-

값이

"default"또는"hardware"이면,[[render quantum size]]를 128로 설정합니다. -

그 밖에 정수가 전달된 경우, User-Agent가 이 값을 반영하여

[[render quantum size]]를 설정할 수 있습니다.

-

-

AudioDestinationNode를contextOptions.numberOfChannels값으로channelCount를 설정하여 생성합니다. -

messageChannel을 새

MessageChannel로 만듭니다. -

controlSidePort를 messageChannel의

port1값으로 둡니다. -

renderingSidePort를 messageChannel의

port2값으로 둡니다. -

serializedRenderingSidePort를 StructuredSerializeWithTransfer(renderingSidePort, « renderingSidePort ») 결과로 둡니다.

-

이

audioWorklet의port를 controlSidePort로 설정합니다. -

제어 메시지 큐잉을 통해 AudioContextGlobalScope에 MessagePort 설정을 serializedRenderingSidePort로 실행합니다.

OfflineAudioContext.constructor(contextOptions) 메서드의 인수. 파라미터 타입 Nullable Optional 설명 contextOptions이 컨텍스트를 생성하는 데 필요한 초기 파라미터. -

OfflineAudioContext(numberOfChannels, length, sampleRate)-

OfflineAudioContext는 AudioContext.createBuffer와 동일한 인수로 생성할 수 있습니다. 인수 중 하나라도 음수, 0, 또는 허용 범위를 벗어나면NotSupportedError예외가 반드시 발생해야 합니다.OfflineAudioContext는 아래와 같이 생성한 것과 동일하게 동작합니다.

new OfflineAudioContext({ numberOfChannels: numberOfChannels, length: length, sampleRate: sampleRate}) 를 호출한 것과 같습니다.

OfflineAudioContext.constructor(numberOfChannels, length, sampleRate) 메서드의 인수. 파라미터 타입 Nullable Optional 설명 numberOfChannelsunsigned long✘ ✘ 버퍼의 채널 수를 결정합니다. 지원 채널 수는 createBuffer()참조.lengthunsigned long✘ ✘ 버퍼의 크기(샘플 프레임 단위)를 결정합니다. sampleRatefloat✘ ✘ 버퍼 내 선형 PCM 오디오 데이터의 샘플레이트(초당 샘플 프레임 수)를 설명합니다. 유효 샘플레이트는 createBuffer()참조.

1.3.2. 속성

length, 타입 unsigned long, 읽기 전용-

버퍼의 크기(샘플 프레임 단위). 생성자의

length파라미터 값과 동일합니다. oncomplete, 타입 EventHandler-

이 이벤트 핸들러의 이벤트 타입은

complete입니다. 이벤트는OfflineAudioCompletionEvent인터페이스를 사용하여 디스패치됩니다.OfflineAudioContext에서 발생하는 마지막 이벤트입니다.

1.3.3. 메서드

startRendering()-

현재 연결과 예약된 변경 사항을 기반으로 오디오 렌더링을 시작합니다.

렌더링된 오디오 데이터를 얻는 주요 방법은 반환된 promise를 사용하는 것이지만, 인스턴스는 레거시 이유로

complete라는 이벤트도 발생시킵니다.[[rendering started]]는 이OfflineAudioContext의 내부 슬롯입니다. 이 슬롯을 false로 초기화합니다.startRendering이 호출되면 다음 단계는 컨트롤 스레드에서 반드시 수행되어야 합니다:- this의 관련 글로벌 객체의 연관된 Document가 완전히 활성화되어 있지 않다면, promise를 reject하고 "

InvalidStateError"DOMException을 반환합니다. [[rendering started]]슬롯이 true라면,InvalidStateError로 reject된 promise를 반환하고, 이 단계를 중단합니다.[[rendering started]]슬롯을 true로 설정합니다.- promise를 새 promise로 생성합니다.

- 채널 수, 길이, 샘플레이트가 해당 인스턴스의 생성자

contextOptions파라미터로 전달된numberOfChannels,length,sampleRate값과 각각 동일한AudioBuffer를 생성합니다. 이 버퍼를 내부 슬롯[[rendered buffer]]에 할당합니다. - 이전

AudioBuffer생성 과정에서 예외가 발생했다면, 해당 예외로 promise를 reject합니다. - 버퍼가 성공적으로 생성되었다면, 오프라인 렌더링을 시작합니다.

- promise를

[[pending promises]]에 추가합니다. - promise를 반환합니다.

오프라인 렌더링 시작을 위해 다음 단계는 해당 작업을 위해 생성된 렌더링 스레드에서 반드시 실행되어야 합니다.- 현재 연결과 예약된 변경 사항을 기반으로

length샘플 프레임을[[rendered buffer]]에 렌더링합니다. - 각 렌더 퀀텀마다

렌더링을

suspend해야 하는지 확인합니다. - 중단된 컨텍스트가 재개되면, 버퍼 렌더링을 계속합니다.

-

렌더링이 완료되면 미디어 요소 태스크를 큐에 추가하여 다음 단계를 실행합니다:

startRendering()에서 생성된 promise를[[rendered buffer]]로 resolve합니다.- 미디어 요소 태스크를 큐에 추가하여 이벤트를 발생시킵니다. 이벤트 이름은

complete이며,OfflineAudioContext에서OfflineAudioCompletionEvent인스턴스를 사용하고renderedBuffer속성은[[rendered buffer]]로 설정됩니다.

파라미터 없음.반환 타입:Promise<AudioBuffer> - this의 관련 글로벌 객체의 연관된 Document가 완전히 활성화되어 있지 않다면, promise를 reject하고 "

resume()-

OfflineAudioContext의currentTime진행이 중단된 경우, 진행을 다시 시작합니다.resume이 호출되면, 다음 단계를 수행합니다:-

this의 관련 글로벌 객체의 연관된 Document가 완전히 활성화되어 있지 않다면, promise를 reject하고 "

InvalidStateError"DOMException을 반환합니다. -

promise를 새 Promise로 생성합니다.

-

다음 조건 중 하나라도 참이면, 이 단계를 중단하고 promise를

InvalidStateError로 reject합니다:-

[[control thread state]]값이closed인 경우. -

[[rendering started]]슬롯 값이 false인 경우.

-

-

[[control thread state]]플래그를OfflineAudioContext에서running으로 설정합니다. -

컨트롤 메시지 큐에 추가하여

OfflineAudioContext를 재개합니다. -

promise를 반환합니다.

컨트롤 메시지를 실행하여OfflineAudioContext를 재개한다는 것은 렌더링 스레드에서 다음 단계를 실행한다는 의미입니다:-

[[rendering thread state]]값을running으로 설정합니다. -

오디오 그래프 렌더링을 시작합니다.

-

실패 시 미디어 요소 태스크를 큐에 추가하여 promise를 reject하고 남은 단계를 중단합니다.

-

미디어 요소 태스크를 큐에 추가하여 다음 단계를 실행합니다:

-

promise를 resolve합니다.

-

-

state속성을OfflineAudioContext에서 "running"으로 설정합니다. -

미디어 요소 태스크를 큐에 추가하여 이벤트를 발생시킵니다. 이벤트 이름은

statechange이며,OfflineAudioContext에서 발생합니다.

-

-

파라미터 없음. -

suspend(suspendTime)-

오디오 컨텍스트의 시간 진행을 지정된 시점에 일시 중지하도록 예약하고 promise를 반환합니다. 이는

OfflineAudioContext에서 오디오 그래프를 동기적으로 조작할 때 일반적으로 유용합니다.일시 중지의 최대 정밀도는 렌더 퀀텀 크기이며, 지정한 일시 중지 시간은 가장 가까운 렌더 퀀텀 경계로 올림 처리됩니다. 이로 인해 동일한 양자화 프레임에서 여러 번 suspend를 예약할 수 없습니다. 또한, 정확한 일시 중지를 위해서는 컨텍스트가 실행 중이 아닐 때 예약해야 합니다.

OfflineAudioContext.suspend() 메서드의 인자. 파라미터 타입 Nullable Optional 설명 suspendTimedouble✘ ✘ 지정한 시간에 렌더링을 일시 중지하도록 예약합니다. 이 시간은 양자화되어 렌더 퀀텀 크기에 맞게 올림 처리됩니다. 만약 양자화된 프레임 번호가 - 음수이거나

- 현재 시간 이하이거나

- 전체 렌더링 기간 이상이거나

- 동일한 시간에 다른 suspend가 예약되어 있으면,

InvalidStateError로 reject됩니다.

1.3.4. OfflineAudioContextOptions

이는 OfflineAudioContext를

생성할 때 사용할 옵션을 지정합니다.

dictionary OfflineAudioContextOptions {unsigned long numberOfChannels = 1;required unsigned long length ;required float sampleRate ; (AudioContextRenderSizeCategory or unsigned long )renderSizeHint = "default"; };

1.3.4.1. Dictionary OfflineAudioContextOptions

멤버

length, 타입 unsigned long-

렌더링된

AudioBuffer의 샘플 프레임 길이입니다. numberOfChannels, 타입 unsigned long, 기본값1-

이

OfflineAudioContext의 채널 수입니다. sampleRate, 타입 float-

이

OfflineAudioContext의 샘플레이트입니다. renderSizeHint, 타입(AudioContextRenderSizeCategory or unsigned long), 기본값"default"-

이

OfflineAudioContext의 렌더 퀀텀 크기에 대한 힌트입니다.

1.3.5.

OfflineAudioCompletionEvent

인터페이스

이는 Event

객체로, 레거시 이유로 OfflineAudioContext에

디스패치됩니다.

[Exposed =Window ]interface OfflineAudioCompletionEvent :Event {(constructor DOMString ,type OfflineAudioCompletionEventInit );eventInitDict readonly attribute AudioBuffer renderedBuffer ; };

1.3.5.1. 속성

renderedBuffer, 타입 AudioBuffer, 읽기 전용-

렌더링된 오디오 데이터를 담고 있는

AudioBuffer입니다.

1.3.5.2.

OfflineAudioCompletionEventInit

dictionary OfflineAudioCompletionEventInit :EventInit {required AudioBuffer renderedBuffer ; };

1.3.5.2.1. Dictionary OfflineAudioCompletionEventInit

멤버

renderedBuffer, 타입 AudioBuffer-

이 이벤트의

renderedBuffer속성에 할당될 값입니다.

1.4. AudioBuffer

인터페이스

이 인터페이스는 메모리에 상주하는 오디오 에셋을 나타냅니다. 하나 이상의 채널을 포함할 수 있으며, 각 채널은 32비트 부동소수점 linear PCM 값(명목 범위 \([-1,1]\))을 가진 것으로 보이지만

실제 값은 이 범위에 제한되지 않습니다. 일반적으로 PCM 데이터의 길이는 상당히 짧을 것으로(대개 1분 미만) 예상됩니다.

더 긴 사운드(예: 음악 사운드트랙)의 경우

audio

요소와 MediaElementAudioSourceNode를

이용해 스트리밍해야 합니다.

AudioBuffer

는 하나 이상의 AudioContext에서

사용할 수 있으며,

OfflineAudioContext와

AudioContext

간에 공유할 수 있습니다.

AudioBuffer

는 네 개의 내부 슬롯을 가집니다:

[[number of channels]]-

이

AudioBuffer의 오디오 채널 수로, unsigned long 타입입니다. [[length]]-

이

AudioBuffer의 각 채널 길이로, unsigned long 타입입니다. [[sample rate]]-

이

AudioBuffer의 샘플레이트(Hz)로, float 타입입니다. [[internal data]]-

오디오 샘플 데이터를 저장하는 data block입니다.

[Exposed =Window ]interface AudioBuffer {constructor (AudioBufferOptions );options readonly attribute float sampleRate ;readonly attribute unsigned long length ;readonly attribute double duration ;readonly attribute unsigned long numberOfChannels ;Float32Array getChannelData (unsigned long );channel undefined copyFromChannel (Float32Array ,destination unsigned long ,channelNumber optional unsigned long = 0);bufferOffset undefined copyToChannel (Float32Array ,source unsigned long ,channelNumber optional unsigned long = 0); };bufferOffset

1.4.1. 생성자

AudioBuffer(options)-

-

options값 중 어떤 값이라도 명목 범위를 벗어나면NotSupportedError예외를 던지고 이후 단계를 중단합니다. -

b를 새

AudioBuffer객체로 생성합니다. -

생성자에 전달된

AudioBufferOptions의numberOfChannels,length,sampleRate속성 값을 각각 내부 슬롯[[number of channels]],[[length]],[[sample rate]]에 할당합니다. -

이

AudioBuffer의 내부 슬롯[[internal data]]를CreateByteDataBlock(호출 결과로 설정합니다.[[length]]*[[number of channels]])참고: 이는 기본 저장소를 0으로 초기화합니다.

-

b를 반환합니다.

AudioBuffer.constructor() 메서드의 인자. 파라미터 타입 Nullable Optional 설명 optionsAudioBufferOptions✘ ✘ 이 AudioBuffer의 속성을 결정하는AudioBufferOptions입니다. -

1.4.2. 속성

duration, 타입 double, 읽기 전용-

PCM 오디오 데이터의 초 단위 길이입니다.

이 값은

[[sample rate]]와[[length]]를 이용해AudioBuffer에서[[length]]를[[sample rate]]로 나누어 계산합니다. length, 타입 unsigned long, 읽기 전용-

PCM 오디오 데이터의 샘플 프레임 단위 길이.

[[length]]값을 반환해야 합니다. numberOfChannels, 타입 unsigned long, 읽기 전용-

개별 오디오 채널의 개수.

[[number of channels]]값을 반환해야 합니다. sampleRate, 타입 float, 읽기 전용-

PCM 오디오 데이터의 초당 샘플 수.

[[sample rate]]값을 반환해야 합니다.

1.4.3. 메서드

copyFromChannel(destination, channelNumber, bufferOffset)-

copyFromChannel()메서드는 지정한AudioBuffer의 채널에서destination배열로 샘플을 복사합니다.buffer를 \(N_b\) 프레임을 가진AudioBuffer로, \(N_f\)를destination배열의 요소 개수로, \(k\)를bufferOffset값으로 두면,buffer에서destination으로 복사되는 프레임 개수는 \(\max(0, \min(N_b - k, N_f))\)입니다. 만약 이 값이 \(N_f\)보다 작으면destination의 나머지 요소는 수정되지 않습니다.AudioBuffer.copyFromChannel() 메서드 인자. 파라미터 타입 Nullable Optional 설명 destinationFloat32Array✘ ✘ 채널 데이터를 복사할 배열. channelNumberunsigned long✘ ✘ 데이터를 복사할 채널의 인덱스. channelNumber가AudioBuffer의 채널 수 이상이면,IndexSizeError를 반드시 throw해야 합니다.bufferOffsetunsigned long✘ ✔ 옵션 오프셋 (기본값 0). AudioBuffer에서 해당 오프셋부터destination으로 복사됨.반환 타입:undefined copyToChannel(source, channelNumber, bufferOffset)-

copyToChannel()메서드는source배열에서 지정한AudioBuffer의 채널로 샘플을 복사합니다.UnknownError는source를 버퍼로 복사할 수 없을 때 throw될 수 있습니다.buffer를 \(N_b\) 프레임을 가진AudioBuffer로, \(N_f\)를source배열의 요소 개수로, \(k\)를bufferOffset값으로 두면,source에서buffer로 복사되는 프레임 개수는 \(\max(0, \min(N_b - k, N_f))\)입니다. 만약 이 값이 \(N_f\)보다 작으면 buffer의 나머지 요소는 수정되지 않습니다.AudioBuffer.copyToChannel() 메서드 인자. 파라미터 타입 Nullable Optional 설명 sourceFloat32Array✘ ✘ 채널 데이터가 복사될 배열. channelNumberunsigned long✘ ✘ 데이터를 복사할 채널의 인덱스. channelNumber가AudioBuffer의 채널 수 이상이면,IndexSizeError를 반드시 throw해야 합니다.bufferOffsetunsigned long✘ ✔ 옵션 오프셋(기본값 0). source에서 이 오프셋부터AudioBuffer로 복사됨.반환 타입:undefined getChannelData(channel)-

acquire the content 규칙에 따라 쓰기 또는 복사본 획득을 허용하며,

[[internal data]]에 저장된 바이트를 새로운Float32Array로 반환합니다.UnknownError는[[internal data]]또는 새로운Float32Array를 생성할 수 없을 때 throw될 수 있습니다.AudioBuffer.getChannelData() 메서드 인자. 파라미터 타입 Nullable Optional 설명 channelunsigned long✘ ✘ 데이터를 가져올 채널의 인덱스. 0은 첫 번째 채널을 의미하며, 이 인덱스 값은 [[number of channels]]보다 작아야 하며, 아니면IndexSizeError예외를 반드시 throw해야 합니다.반환 타입:Float32Array

참고: copyToChannel()

및 copyFromChannel()

은 Float32Array

뷰를 사용해 큰 배열의 일부만 채울 수 있습니다.

AudioBuffer의

채널 데이터를 읽고, 데이터를 청크 단위로 처리할 때는 copyFromChannel()

을 사용하는 것이 getChannelData()

를 호출하여 결과 배열에 접근하는 것보다

불필요한 메모리 할당과 복사를 줄일 수 있어 더 바람직합니다.

AudioBuffer의

내용을 API 구현에서 필요로 할 때 acquire the

contents of an AudioBuffer 내부 연산이 호출됩니다. 이 연산은 호출자에게 불변 채널 데이터를 반환합니다.

AudioBuffer에서

발생하면 다음 단계를 실행합니다:

-

해당

AudioBuffer의ArrayBuffer중 하나라도 detached 상태라면true를 반환하고, 단계를 중단하며, 호출자에게 길이가 0인 채널 데이터 버퍼를 반환합니다. -

이

AudioBuffer의ArrayBuffer중getChannelData()에서 반환한 배열에 대해 모두 Detach를 수행합니다.참고:

AudioBuffer는createBuffer()또는AudioBuffer생성자를 통해서만 생성되므로, 이는 throw되지 않습니다. -

해당

[[internal data]]를ArrayBuffer로부터 보존하고, 호출자에게 참조를 반환합니다. -

복사본 데이터를 담은

ArrayBuffer를AudioBuffer에 연결하여, 다음getChannelData()호출 시 반환합니다.

acquire the contents of an AudioBuffer 연산은 다음의 경우에 호출됩니다:

-

AudioBufferSourceNode.start호출 시, 해당 노드의buffer의 내용을 획득합니다. 실패하면 아무 것도 재생되지 않습니다. -

AudioBufferSourceNode의buffer가 설정되고, 이전에AudioBufferSourceNode.start가 호출된 경우, setter는 내용을 획득합니다. 실패하면 아무 것도 재생되지 않습니다. -

ConvolverNode의buffer가AudioBuffer로 설정될 때, 내용을 획득합니다. -

AudioProcessingEvent디스패치가 완료될 때, 해당 이벤트의outputBuffer의 내용을 획득합니다.

참고: copyToChannel()

은 acquire the

content of an AudioBuffer가 호출된 AudioNode가 현재

사용하는

AudioBuffer의

내용을

변경할 수 없습니다. 해당 AudioNode는 이전에

획득한 데이터를 계속 사용합니다.

1.4.4. AudioBufferOptions

이는 AudioBuffer를

생성할 때 사용할 옵션을 지정합니다.

length와

sampleRate

멤버는 필수입니다.

dictionary AudioBufferOptions {unsigned long numberOfChannels = 1;required unsigned long length ;required float sampleRate ; };

1.4.4.1. Dictionary AudioBufferOptions

멤버

이 딕셔너리의 멤버에 허용되는 값들은 제한됩니다. createBuffer()를

참고하세요.

length, 타입 unsigned long-

버퍼의 샘플 프레임 길이입니다. 제한 사항은

length를 참고하세요. numberOfChannels, 타입 unsigned long, 기본값1-

버퍼의 채널 수. 제한 사항은

numberOfChannels를 참고하세요. sampleRate, 타입 float-

버퍼의 샘플레이트(Hz). 제한 사항은

sampleRate를 참고하세요.

1.5. AudioNode

인터페이스

AudioNode는

AudioContext의

빌딩 블록입니다.

이 인터페이스는

오디오 소스, 오디오 목적지, 그리고 중간 처리 모듈을 나타냅니다. 이러한 모듈들은 서로 연결되어 오디오 하드웨어에 오디오를 렌더링하기 위한 처리

그래프를 구성할 수 있습니다.

각 노드는 입력 및/또는 출력을 가질 수 있습니다. 소스 노드는 입력이 없고 출력이 하나입니다. 대부분의 필터와 같은 처리 노드는 입력 하나와 출력 하나를 가집니다.

각 AudioNode의

오디오 처리 방법은 세부적으로 다르지만, 일반적으로 AudioNode는

입력(있는 경우)을 처리하고 출력(있는 경우)을 생성합니다.

각 출력은 하나 이상의 채널을 가집니다. 정확한 채널 수는 해당 AudioNode의 세부

사항에 따라 달라집니다.

출력은 하나 이상의 AudioNode 입력에

연결될 수 있으므로 fan-out이 지원됩니다. 입력은 처음엔 연결이 없지만 하나 이상의 AudioNode 출력에서

연결될 수 있으므로 fan-in도 지원됩니다.

connect() 메서드를 사용해 AudioNode의 출력을

다른 AudioNode의 입력에

연결하면,

이를 입력에 대한 연결이라고 합니다.

각 AudioNode

입력은 언제든 특정 채널 수를 가집니다. 이 수는 입력에

대한 연결에 따라 달라질 수 있습니다. 입력에 연결이 없으면 한

채널(무음)을 가집니다.

각 입력에 대해 AudioNode는

해당 입력에 대한 모든 연결을 믹싱합니다.

규범적 요구사항과 세부 사항은 § 4 채널 업믹싱과 다운믹싱에서 참고하세요.

입력 처리 및 AudioNode의 내부

동작은

AudioContext

시간에 따라 연결된 출력이 있든 없든,

그리고 이 출력이 궁극적으로 AudioContext의

AudioDestinationNode에

도달하든 상관없이

계속적으로 이루어집니다.

[Exposed =Window ]interface AudioNode :EventTarget {AudioNode connect (AudioNode destinationNode ,optional unsigned long output = 0,optional unsigned long input = 0);undefined connect (AudioParam destinationParam ,optional unsigned long output = 0);undefined disconnect ();undefined disconnect (unsigned long output );undefined disconnect (AudioNode destinationNode );undefined disconnect (AudioNode destinationNode ,unsigned long output );undefined disconnect (AudioNode destinationNode ,unsigned long output ,unsigned long input );undefined disconnect (AudioParam destinationParam );undefined disconnect (AudioParam destinationParam ,unsigned long output );readonly attribute BaseAudioContext context ;readonly attribute unsigned long numberOfInputs ;readonly attribute unsigned long numberOfOutputs ;attribute unsigned long channelCount ;attribute ChannelCountMode channelCountMode ;attribute ChannelInterpretation channelInterpretation ; };

1.5.1. AudioNode 생성

AudioNode는 두

가지 방법으로 생성할 수 있습니다. 해당 인터페이스의 생성자를 사용하거나, BaseAudioContext

또는 AudioContext에서

팩토리 메서드를 사용하는 방법입니다.

BaseAudioContext가

AudioNode

생성자의 첫 번째 인자로 전달되면, 생성될 AudioNode의

연결된 BaseAudioContext라고

합니다.

마찬가지로 팩토리 메서드를 사용할 때, 연결된

BaseAudioContext는 해당 팩토리 메서드를 호출하는 BaseAudioContext가

됩니다.

AudioNode를 팩토리 메서드로 BaseAudioContext

c에서 생성하려면 다음 단계를 수행합니다:

-

node를 타입 n의 새 객체로 만듭니다.

-

option을 해당 팩토리 메서드와 연결된 인터페이스의 연결된 딕셔너리 타입으로 만듭니다.

-

팩토리 메서드에 전달된 각 파라미터에 대해 option의 동일한 이름의 멤버에 해당 값을 설정합니다.

-

node에 c와 option을 인자로 하여 n의 생성자를 호출합니다.

-

node를 반환합니다.

AudioNode를

상속하는 객체 o에 대해,

해당 인터페이스의 생성자에 전달된 context, dict 인자를 가지고 다음 단계를 실행하는 것을 의미합니다.

-

o의 연결된

BaseAudioContext를 context로 설정합니다. -

이 인터페이스의 각

numberOfInputs,numberOfOutputs,channelCount,channelCountMode,channelInterpretation값을 해당AudioNode에 대한 섹션에 명시된 기본값으로 설정합니다. -

dict의 각 멤버에 대해 다음 단계를 실행합니다. k는 멤버의 키, v는 값입니다. 이 과정에서 예외가 발생하면 반복을 중단하고 해당 예외를 호출자(생성자 또는 팩토리 메서드)로 전달합니다.

-

k가 이 인터페이스의

AudioParam이름이면, 해당value속성을 v로 설정합니다. -

그 외에 k가 이 인터페이스의 속성 이름이면 해당 속성 객체를 v로 설정합니다.

-

연결된 인터페이스란 팩토리 메서드에서 반환되는 객체의 인터페이스입니다. 연결된 옵션 객체란 해당 인터페이스의 생성자에 전달할 수 있는 옵션 객체입니다.

AudioNode는

EventTarget입니다.

[DOM]에 설명된 대로,

AudioNode에

이벤트를 디스패치할 수 있습니다. 이는 다른 EventTarget이

이벤트를 받을 수 있는 것과 동일합니다.

enum {ChannelCountMode "max" ,"clamped-max" ,"explicit" };

ChannelCountMode는

노드의 channelCount

및 channelInterpretation

값과 함께,

입력 채널 믹싱 방식을 결정하는 computedNumberOfChannels을 결정하는 데 사용됩니다. computedNumberOfChannels는 아래와

같이 결정됩니다. 믹싱 방법 상세는 § 4 채널 업믹싱과 다운믹싱을 참고하세요.

| 열거값 | 설명 |

|---|---|

"max"

| computedNumberOfChannels는 입력에 연결된 모든 채널 수 중

최대값입니다. 이 모드에서는 channelCount가

무시됩니다.

|

"clamped-max"

| computedNumberOfChannels는 "max"와

동일하게 결정되고, 그 값이 channelCount의

최대값으로 제한됩니다.

|

"explicit"

| computedNumberOfChannels는 channelCount에

명시된 정확한 값입니다.

|

enum {ChannelInterpretation "speakers" ,"discrete" };

| 열거값 | 설명 |

|---|---|

"speakers"

| 업믹스 방정식 또는 다운믹스 방정식을 사용합니다. 채널 수가 기본 스피커

레이아웃과 일치하지 않는 경우 "discrete"로

전환합니다.

|

"discrete"

| 채널 수가 다 소진될 때까지 채널을 채운 후 남은 채널을 0으로 채웁니다(업믹스). 다운믹스 시 가능한 채널만 채우고 나머지 채널은 버립니다. |

1.5.2. AudioNode 테일 타임

AudioNode는

테일 타임을 가질 수 있습니다. 즉, AudioNode에 무음이

입력되어도 출력이 무음이 아닐 수 있습니다.

AudioNode는 내부

처리 상태에 따라 과거 입력이 미래 출력에 영향을 주는 경우 0이 아닌 테일 타임을 가집니다. AudioNode는 입력이

무음으로 전환된 이후에도 계산된 테일 타임 동안 무음이 아닌 출력을 계속 생성할 수 있습니다.

1.5.3. AudioNode 생명주기

AudioNode는 다음

조건 중 하나라도 만족하면 렌더 퀀텀 동안 활성 처리 중일 수 있습니다.

-

AudioScheduledSourceNode는 오직 현재 렌더링 퀀텀의 일부라도 재생 중일 때 활성 처리 중입니다. -

MediaElementAudioSourceNode는 해당mediaElement가 현재 렌더링 퀀텀의 일부라도 재생 중일 때 활성 처리 중입니다. -

MediaStreamAudioSourceNode또는MediaStreamTrackAudioSourceNode는 연결된MediaStreamTrack객체가readyState속성이"live"이고muted가false,enabled가true일 때 활성 처리 중입니다. -

순환 구조 내의

DelayNode는 현재 렌더 퀀텀의 출력 샘플 절대값이 \( 2^{-126} \) 이상일 때만 활성 처리 중입니다. -

ScriptProcessorNode는 입력 또는 출력이 연결되어 있을 때 활성 처리 중입니다. -

AudioWorkletNode는 해당AudioWorkletProcessor의[[callable process]]가true를 반환하고, active source 플래그가true이거나, 입력으로 연결된AudioNode중 하나라도 활성 처리 중일 때 활성 처리 중입니다. -

그 밖의 모든

AudioNode는 입력으로 연결된AudioNode중 하나라도 활성 처리 중이면 활성 처리 중이 되고, 입력으로부터 받은 활성 처리 중AudioNode가 더 이상 출력에 영향을 주지 않으면 활성 처리 중이 아닙니다.

참고: 이는 테일 타임을 가진 AudioNode도

고려합니다.

활성 처리 중이 아닌 AudioNode는 한

채널의 무음만 출력합니다.

1.5.4. 속성

channelCount, 타입 unsigned long-

channelCount는 노드의 입력 연결에 대해 업믹싱과 다운믹싱에 사용되는 채널 수입니다. 기본값은 2이며, 특정 노드에서는 특별히 결정된 값이 사용됩니다. 입력이 없는 노드에는 이 속성이 영향을 주지 않습니다. 이 값을 0 또는 구현 최대 채널 수를 초과하는 값으로 설정하면, 구현은 반드시NotSupportedError예외를 던져야 합니다.또한 일부 노드는 채널 수에 대해 추가 channelCount 제약을 가집니다:

AudioDestinationNode-

동작은 목적지 노드가

AudioContext또는OfflineAudioContext의 목적지인지에 따라 달라집니다:AudioContext-

채널 수는 1에서

maxChannelCount사이여야 합니다. 이 범위를 벗어나 설정하면IndexSizeError예외를 반드시 던져야 합니다. OfflineAudioContext-

채널 수는 변경할 수 없습니다. 값을 변경하려 하면

InvalidStateError예외를 반드시 던져야 합니다.

AudioWorkletNode-

자세한 내용은 § 1.32.4.3.2 AudioWorkletNodeOptions로 채널 구성를 참고하세요.

ChannelMergerNode-

채널 수는 변경할 수 없으며, 값을 변경하려 하면

InvalidStateError예외를 반드시 던져야 합니다. ChannelSplitterNode-

채널 수는 변경할 수 없으며, 값을 변경하려 하면

InvalidStateError예외를 반드시 던져야 합니다. ConvolverNode-

채널 수는 2를 초과할 수 없으며, 2를 초과하는 값으로 변경하려 하면

NotSupportedError예외를 반드시 던져야 합니다. DynamicsCompressorNode-

채널 수는 2를 초과할 수 없으며, 2를 초과하는 값으로 변경하려 하면

NotSupportedError예외를 반드시 던져야 합니다. PannerNode-

채널 수는 2를 초과할 수 없으며, 2를 초과하는 값으로 변경하려 하면

NotSupportedError예외를 반드시 던져야 합니다. ScriptProcessorNode-

채널 수는 변경할 수 없으며, 값을 변경하려 하면

NotSupportedError예외를 반드시 던져야 합니다. StereoPannerNode-

채널 수는 2를 초과할 수 없으며, 2를 초과하는 값으로 변경하려 하면

NotSupportedError예외를 반드시 던져야 합니다.

이 속성에 대한 자세한 내용은 § 4 채널 업믹싱과 다운믹싱을 참고하세요.

channelCountMode, 타입 ChannelCountMode-

channelCountMode는 노드의 입력 연결에 대해 업믹싱과 다운믹싱 시 채널 수를 어떻게 결정할지 지정합니다. 기본값은 "max"입니다. 입력이 없는 노드에는 이 속성이 영향을 주지 않습니다.또한 일부 노드는 channelCountMode 값에 대해 추가 channelCountMode 제약을 가집니다:

AudioDestinationNode-

AudioDestinationNode가destination노드이면서OfflineAudioContext의 목적지인 경우 channelCountMode는 변경할 수 없습니다. 값을 변경하려 하면InvalidStateError예외를 반드시 던져야 합니다. ChannelMergerNode-

channelCountMode는 "

explicit"에서 변경할 수 없으며, 값을 변경하려 하면InvalidStateError예외를 반드시 던져야 합니다. ChannelSplitterNode-

channelCountMode는 "

explicit"에서 변경할 수 없으며, 값을 변경하려 하면InvalidStateError예외를 반드시 던져야 합니다. ConvolverNode-

channelCountMode를 "

max"로 설정할 수 없으며, 그러한 시도에 대해NotSupportedError예외를 반드시 던져야 합니다. DynamicsCompressorNode-

channelCountMode를 "

max"로 설정할 수 없으며, 그러한 시도에 대해NotSupportedError예외를 반드시 던져야 합니다. PannerNode-

channelCountMode를 "

max"로 설정할 수 없으며, 그러한 시도에 대해NotSupportedError예외를 반드시 던져야 합니다. ScriptProcessorNode-

channelCountMode는 "

explicit"에서 변경할 수 없으며, 값을 변경하려 하면NotSupportedError예외를 반드시 던져야 합니다. StereoPannerNode-

channelCountMode를 "

max"로 설정할 수 없으며, 그러한 시도에 대해NotSupportedError예외를 반드시 던져야 합니다.

이 속성에 대한 자세한 내용은 § 4 채널 업믹싱과 다운믹싱을 참고하세요.

channelInterpretation, 타입 ChannelInterpretation-

channelInterpretation는 노드의 입력 연결에 대해 업믹싱과 다운믹싱 시 개별 채널을 어떻게 처리할지 지정합니다. 기본값은 "speakers"입니다. 입력이 없는 노드에는 이 속성이 영향을 주지 않습니다.또한 일부 노드는 channelInterpretation 값에 대해 추가 channelInterpretation 제약을 가집니다:

ChannelSplitterNode-

channelInterpretation은 "

discrete"에서 변경할 수 없으며, 값을 변경하려 하면InvalidStateError예외를 반드시 던져야 합니다.

이 속성에 대한 자세한 내용은 § 4 채널 업믹싱과 다운믹싱을 참고하세요.

context, 타입 BaseAudioContext, 읽기 전용-

이

AudioNode를 소유하는BaseAudioContext입니다. numberOfInputs, 타입 unsigned long, 읽기 전용-

이

AudioNode로 입력되는 입력 수입니다. 소스 노드의 경우 0입니다. 이 속성은 많은AudioNode타입에서 미리 결정되어 있지만,ChannelMergerNode나AudioWorkletNode처럼 입력 수가 가변적인 노드도 있습니다. numberOfOutputs, 타입 unsigned long, 읽기 전용-

이

AudioNode에서 나오는 출력 수입니다. 이 속성은 일부AudioNode타입에서 미리 결정되어 있지만,ChannelSplitterNode나AudioWorkletNode처럼 출력 수가 가변적인 노드도 있습니다.

1.5.5. 메서드

connect(destinationNode, output, input)-

특정 노드의 한 출력과 다른 특정 노드의 한 입력 사이에는 오직 하나의 연결만 존재할 수 있습니다. 동일한 결합점에 대해 여러 번 연결을 시도해도 무시됩니다.

이 메서드는

destinationAudioNode객체를 반환합니다.AudioNode.connect(destinationNode, output, input) 메서드 인자. 파라미터 타입 Nullable Optional 설명 destinationNodedestination파라미터는 연결할AudioNode입니다.destination파라미터가 다른AudioContext에서 생성된AudioNode라면InvalidAccessError를 반드시 던져야 합니다. 즉,AudioNode는 서로 다른AudioContext간에 공유할 수 없습니다. 여러AudioNode를 같은AudioNode에 연결할 수 있으며, 이는 채널 업믹싱과 다운믹싱 섹션에서 설명됩니다.outputunsigned long✘ ✔ output파라미터는 연결할AudioNode의 출력 인덱스입니다. 이 파라미터가 범위를 벗어나면IndexSizeError예외를 반드시 던져야 합니다. 하나의AudioNode출력은 여러 입력에 연결할 수 있으므로 "팬-아웃"이 지원됩니다.inputinput파라미터는 대상AudioNode의 입력 인덱스입니다. 이 파라미터가 범위를 벗어나면IndexSizeError예외를 반드시 던져야 합니다. 하나의AudioNode를 다른AudioNode에 연결하여, 순환(cycle)을 만들 수 있습니다: 한AudioNode가 다른AudioNode에 연결되고, 이것이 다시 첫 번째AudioNode의 입력 또는AudioParam에 연결될 수 있습니다.반환 타입:AudioNode connect(destinationParam, output)-

AudioNode를AudioParam에 연결하여, 해당 파라미터 값을 a-rate 신호로 제어합니다.하나의

AudioNode출력은 여러AudioParam에 여러 번 connect() 호출로 연결할 수 있으므로 "팬-아웃"이 지원됩니다.여러

AudioNode출력은 하나의AudioParam에 여러 번 connect() 호출로 연결할 수 있으므로 "팬-인"이 지원됩니다.AudioParam은 연결된AudioNode출력의 렌더링 오디오 데이터를 받아서, 이미 모노가 아니면 다운믹스하여 모노로 변환 후, 다른 출력들과 함께 믹싱합니다. 마지막으로 내재적 파라미터 값(AudioParam이 오디오 연결 없이 갖는value값)과, 해당 파라미터에 예약된 타임라인 변경도 함께 믹싱합니다.모노로 다운믹스하는 것은

AudioNode의channelCount= 1,channelCountMode= "explicit",channelInterpretation= "speakers"인 경우와 동일합니다.특정 노드의 한 출력과 특정

AudioParam사이에는 오직 하나의 연결만 존재할 수 있으며, 동일한 결합점에 대해 여러 번 연결을 시도해도 무시됩니다.AudioNode.connect(destinationParam, output) 메서드 인자. 파라미터 타입 Nullable Optional 설명 destinationParamAudioParam✘ ✘ destination파라미터는 연결할AudioParam입니다. 이 메서드는destinationAudioParam객체를 반환하지 않습니다.destinationParam이AudioNode에 속해 있고, 그BaseAudioContext가 이 메서드를 호출한AudioNode를 생성한BaseAudioContext와 다르면InvalidAccessError를 반드시 던져야 합니다.outputunsigned long✘ ✔ output파라미터는 연결할AudioNode의 출력 인덱스입니다.parameter가 범위를 벗어나면IndexSizeError예외를 반드시 던져야 합니다.반환 타입:undefined disconnect()-

이

AudioNode에서 나가는 모든 연결을 끊습니다.파라미터 없음.반환 타입:undefined disconnect(output)-

이

AudioNode의 특정 출력에서 연결된 모든AudioNode또는AudioParam객체와의 연결을 끊습니다.AudioNode.disconnect(output) 메서드 인자. 파라미터 타입 Nullable Optional 설명 outputunsigned long✘ ✘ 끊을 AudioNode의 출력 인덱스입니다. 해당 출력에서 나가는 모든 연결을 끊습니다. 이 파라미터가 범위를 벗어나면IndexSizeError예외를 반드시 던져야 합니다.반환 타입:undefined disconnect(destinationNode)-

이

AudioNode에서 특정 목적지AudioNode로 가는 모든 출력을 끊습니다.AudioNode.disconnect(destinationNode) 메서드 인자. 파라미터 타입 Nullable Optional 설명 destinationNodedestinationNode파라미터는 연결을 끊을AudioNode입니다. 해당 목적지로 가는 모든 연결을 끊습니다. 연결이 없으면InvalidAccessError예외를 반드시 던져야 합니다.반환 타입:undefined disconnect(destinationNode, output)-

이

AudioNode의 특정 출력에서 특정 목적지AudioNode의 모든 입력과의 연결을 끊습니다.AudioNode.disconnect(destinationNode, output) 메서드 인자. 파라미터 타입 Nullable Optional 설명 destinationNodedestinationNode파라미터는 연결을 끊을AudioNode입니다. 해당 출력에서 해당 목적지로 연결이 없으면InvalidAccessError예외를 반드시 던져야 합니다.outputunsigned long✘ ✘ 끊을 AudioNode의 출력 인덱스입니다. 이 파라미터가 범위를 벗어나면IndexSizeError예외를 반드시 던져야 합니다.반환 타입:undefined disconnect(destinationNode, output, input)-

이

AudioNode의 특정 출력에서 특정 목적지AudioNode의 특정 입력과의 연결을 끊습니다.AudioNode.disconnect(destinationNode, output, input) 메서드 인자. 파라미터 타입 Nullable Optional 설명 destinationNodedestinationNode파라미터는 연결을 끊을AudioNode입니다. 해당 출력에서 해당 목적지의 해당 입력으로의 연결이 없으면InvalidAccessError예외를 반드시 던져야 합니다.outputunsigned long✘ ✘ 끊을 AudioNode의 출력 인덱스입니다. 이 파라미터가 범위를 벗어나면IndexSizeError예외를 반드시 던져야 합니다.input끊을 대상 AudioNode의 입력 인덱스입니다. 이 파라미터가 범위를 벗어나면IndexSizeError예외를 반드시 던져야 합니다.반환 타입:undefined disconnect(destinationParam)-

이

AudioNode에서 특정 목적지AudioParam으로 가는 모든 출력을 끊습니다. 이AudioNode가 계산된 파라미터 값에 기여하는 값은 이 작업이 적용되면 0이 됩니다. 내재적 파라미터 값에는 영향이 없습니다.AudioNode.disconnect(destinationParam) 메서드 인자. 파라미터 타입 Nullable Optional 설명 destinationParamAudioParam✘ ✘ destinationParam파라미터는 연결을 끊을AudioParam입니다. 연결이 없으면InvalidAccessError예외를 반드시 던져야 합니다.반환 타입:undefined disconnect(destinationParam, output)-

이

AudioNode의 특정 출력에서 특정 목적지AudioParam과의 연결을 끊습니다. 이AudioNode가 계산된 파라미터 값에 기여하는 값은 이 작업이 적용되면 0이 됩니다. 내재적 파라미터 값에는 영향이 없습니다.AudioNode.disconnect(destinationParam, output) 메서드 인자. 파라미터 타입 Nullable Optional 설명 destinationParamAudioParam✘ ✘ destinationParam파라미터는 연결을 끊을AudioParam입니다. 연결이 없으면InvalidAccessError예외를 반드시 던져야 합니다.outputunsigned long✘ ✘ 끊을 AudioNode의 출력 인덱스입니다.parameter가 범위를 벗어나면IndexSizeError예외를 반드시 던져야 합니다.반환 타입:undefined

1.5.6.

AudioNodeOptions

이는 모든 AudioNode를

생성할 때 사용할 수 있는 옵션을 지정합니다.

모든 멤버는 선택 사항입니다. 하지만 실제로 각 노드에 사용되는 값은 해당 노드에 따라 달라집니다.

dictionary AudioNodeOptions {unsigned long channelCount ;ChannelCountMode channelCountMode ;ChannelInterpretation channelInterpretation ; };

1.5.6.1. 딕셔너리 AudioNodeOptions

멤버

channelCount, 타입 unsigned long-

channelCount속성에 대한 원하는 채널 수입니다. channelCountMode, 타입 ChannelCountMode-

channelCountMode속성에 대한 원하는 모드입니다. channelInterpretation, 타입 ChannelInterpretation-

channelInterpretation속성에 대한 원하는 모드입니다.

1.6. AudioParam

인터페이스

AudioParam

은 AudioNode의 세부

동작(예: 볼륨)을 제어합니다.

파라미터는 value 속성을 사용해 즉시 특정 값으로 설정할 수 있습니다. 또는 값의 변화를 AudioContext의

currentTime

속성의 시간 좌표계에서 매우 정밀한 시점에 맞춰 예약할 수 있습니다(엔벌로프, 볼륨 페이드, LFO, 필터 스윕, 그레인 윈도 등). 이런 방식으로

임의의 타임라인 기반 자동화 곡선을 모든 AudioParam에

설정할 수 있습니다.

또한 AudioNode의 출력

오디오 신호를 AudioParam에

연결해 내재적 파라미터 값과 합산할 수도 있습니다.

일부 합성 및 처리 AudioNode는

AudioParam

속성을 가지며, 해당 값은 오디오 샘플마다 반드시 반영되어야 합니다. 그 외의 AudioParam는

샘플 단위 정확도가 중요하지 않으므로 값의 변화를 더 느슨하게 샘플링할 수 있습니다. 각 AudioParam마다

a-rate 파라미터(오디오 샘플마다 반드시 반영)인지 k-rate 파라미터인지 명시됩니다.

구현체는 반드시 블록 단위로 처리해야 하며, 각 AudioNode는 한

렌더 퀀텀을 처리합니다.

각 렌더 퀀텀마다 k-rate 파라미터의 값은 첫 번째 샘플 프레임 시점에

샘플링되어 그 블록 전체에서 사용됩니다. a-rate

파라미터는 블록 내 모든 샘플 프레임마다 샘플링됩니다.

AudioParam마다

automationRate 속성을 "a-rate"

또는 "k-rate"로

설정해 동작 속도를 제어할 수 있습니다.

개별 AudioParam의

설명을 참고하세요.

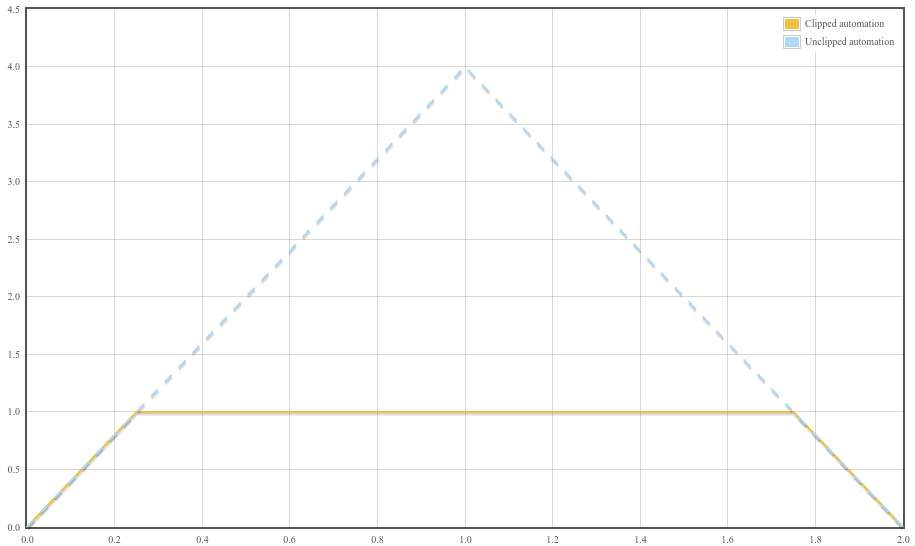

각 AudioParam

에는 minValue

와 maxValue

속성이 포함되어 있으며, 이 두 속성은 파라미터의 단순 명목 범위를 구성합니다. 실제로 파라미터의 값은 \([\mathrm{minValue},

\mathrm{maxValue}]\) 범위로 클램프(clamp)됩니다. 자세한 내용은 § 1.6.3 값의 계산을 참조하세요.

많은 AudioParam에

대해 minValue와

maxValue는

최대 허용 범위로 설정하는 것이 권장됩니다. 이때 maxValue는

최대 단정도

float 값인 3.4028235e38이어야 합니다.

(단, JavaScript에서는 IEEE-754 배정도 float만 지원하므로 3.4028234663852886e38로 작성해야 합니다.)

마찬가지로 minValue는

최소 단정도

float 값인 -3.4028235e38(즉, 최대 단정도 float의 음수)로 설정해야 합니다.

(JavaScript에서는 -3.4028234663852886e38로 작성해야 합니다.)

AudioParam

은 0개 이상의 자동화 이벤트

리스트를 유지합니다. 각 자동화 이벤트는 해당 파라미터 값이 특정 시간 범위에 어떻게 변화하는지 명시하며, 자동화 이벤트 시간을 AudioContext의

currentTime

시간 좌표계로 사용합니다. 자동화 이벤트 리스트는 이벤트 시간 오름차순으로 관리됩니다.

특정 자동화 이벤트의 동작은 AudioContext의

현재 시간, 해당 이벤트와 리스트 내 인접 이벤트의 자동화 이벤트 시간에 따라 결정됩니다. 다음 자동화 메서드들은 이벤트 리스트에 각 메서드에 특화된

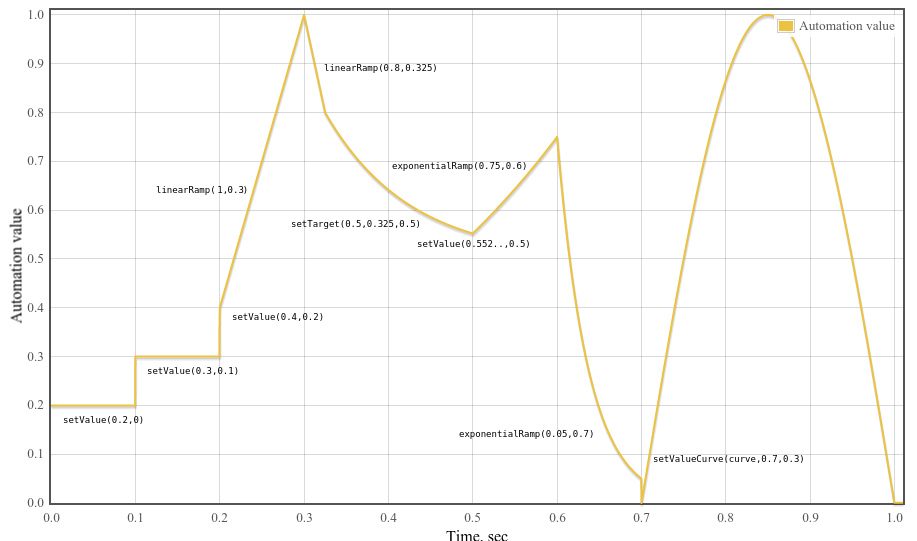

타입의 새 이벤트를 추가합니다:

-

setValueAtTime()-SetValue -

linearRampToValueAtTime()-LinearRampToValue -

exponentialRampToValueAtTime()-ExponentialRampToValue -

setTargetAtTime()-SetTarget -

setValueCurveAtTime()-SetValueCurve

이 메서드를 호출할 때 적용되는 규칙은 다음과 같습니다:

-

자동화 이벤트 시간은 현행 샘플레이트와 관련하여 양자화되지 않습니다. 곡선 및 램프를 결정하는 공식은 이벤트 예약 시 입력한 정확한 실수 시간에 적용됩니다.

-

이미 한 시점에 하나 이상의 이벤트가 있을 때, 새 이벤트를 추가하면 해당 이벤트들 뒤에, 그 이후 시점의 이벤트들 앞에 리스트에 위치하게 됩니다.

-

setValueCurveAtTime()이 시간 \(T\)와 지속 시간 \(D\)로 호출되고, \(T\)보다 크고 \(T + D\)보다 작은 시간에 다른 이벤트가 있다면NotSupportedError예외를 반드시 던져야 합니다. 즉, 값 곡선이 포함된 기간에 다른 이벤트를 예약하는 것은 허용되지 않지만, 곡선이 다른 이벤트와 정확히 같은 시간에 예약되는 것은 허용됩니다. -

마찬가지로, 어떤 자동화 메서드가 \([T, T+D)\) 구간 내(여기서 \(T\)는 곡선의 시작, \(D\)는 지속 시간) 호출되면

NotSupportedError예외를 반드시 던져야 합니다.

참고: AudioParam

속성은 value

속성을 제외하고 모두 읽기 전용입니다.

AudioParam의

automation rate은 automationRate

속성으로 다음 값 중 하나로 설정할 수 있습니다. 단, 일부 AudioParam은

automation rate 변경에 제약이 있습니다.

enum {AutomationRate "a-rate" ,"k-rate" };

| 열거값 | 설명 |

|---|---|

"a-rate"

| 이 AudioParam은

a-rate 처리에 사용됩니다.

|

"k-rate"

| 이 AudioParam은

k-rate 처리에 사용됩니다.

|

각 AudioParam에는

내부 슬롯 [[current value]]이 있으며,

초기값은 해당 AudioParam의

defaultValue입니다.

[Exposed =Window ]interface AudioParam {attribute float value ;attribute AutomationRate automationRate ;readonly attribute float defaultValue ;readonly attribute float minValue ;readonly attribute float maxValue ;AudioParam setValueAtTime (float ,value double );startTime AudioParam linearRampToValueAtTime (float ,value double );endTime AudioParam exponentialRampToValueAtTime (float ,value double );endTime AudioParam setTargetAtTime (float ,target double ,startTime float );timeConstant AudioParam setValueCurveAtTime (sequence <float >,values double ,startTime double );duration AudioParam cancelScheduledValues (double );cancelTime AudioParam cancelAndHoldAtTime (double ); };cancelTime

1.6.1. 속성

automationRate, 타입 AutomationRate-

이

AudioParam의 자동화 속도입니다. 기본값은 실제AudioParam에 따라 다르며, 각AudioParam설명을 참고하세요.일부 노드에는 아래와 같이 추가 automation rate 제약이 있습니다:

AudioBufferSourceNode-

AudioParam의playbackRate와detune는 반드시 "k-rate"이어야 합니다. 속도를 "a-rate"로 변경하면InvalidStateError예외를 반드시 던져야 합니다. DynamicsCompressorNode-

AudioParam의threshold,knee,ratio,attack,release는 반드시 "k-rate"이어야 합니다. 속도를 "a-rate"로 변경하면InvalidStateError예외를 반드시 던져야 합니다. PannerNode-

panningModel이 "HRTF"이면,PannerNode의 모든AudioParam에 대한automationRate설정은 무시됩니다. 마찬가지로AudioListener의 모든AudioParam에 대한automationRate설정도 무시됩니다. 이 경우AudioParam은automationRate가 "k-rate"로 설정된 것과 동일하게 동작합니다.

defaultValue, 타입 float, 읽기 전용-

value속성의 초기값입니다. maxValue, 타입 float, 읽기 전용-

이 파라미터가 가질 수 있는 명목상 최대값입니다.

minValue와 함께 이 파라미터의 명목 범위를 구성합니다. minValue, 타입 float, 읽기 전용-

이 파라미터가 가질 수 있는 명목상 최소값입니다.

maxValue와 함께 이 파라미터의 명목 범위를 구성합니다. value, 타입 float-

파라미터의 부동소수점 값입니다. 이 속성은

defaultValue로 초기화됩니다.이 속성을 가져오면

[[current value]]슬롯의 내용을 반환합니다. 반환값 계산 알고리즘은 § 1.6.3 값의 계산을 참고하세요.이 속성을 설정하면 요청한 값이

[[current value]]슬롯에 할당되고, setValueAtTime()가 현재AudioContext의currentTime과[[current value]]로 호출됩니다.setValueAtTime()에서 던질 예외는 이 속성에 값을 설정할 때도 동일하게 던져집니다.

1.6.2. 메서드

cancelAndHoldAtTime(cancelTime)-

이 메서드는

cancelScheduledValues()와 유사하게cancelTime이상의 시간에 예약된 모든 파라미터 변화를 취소합니다. 추가적으로,cancelTime시점에 발생할 자동화 값이 이후 다른 자동화 이벤트가 등록될 때까지 계속 유지됩니다.자동화가 실행되고

cancelAndHoldAtTime()호출 이후,cancelTime이전에 자동화가 도입될 수 있는 경우 타임라인의 동작은 다소 복잡합니다.cancelAndHoldAtTime()의 동작은 다음 알고리즘에 따라 정의됩니다.\(t_c\)를cancelTime의 값으로 둡니다.-

\(E_1\)을 시간 \(t_1\)의 이벤트(있는 경우)로 둡니다. 여기서 \(t_1\)은 \(t_1 \le t_c\)를 만족하는 가장 큰 값입니다.

-

\(E_2\)를 시간 \(t_2\)의 이벤트(있는 경우)로 둡니다. 여기서 \(t_2\)는 \(t_c \lt t_2\)를 만족하는 가장 작은 값입니다.

-

\(E_2\)가 존재한다면:

-

\(E_2\)가 선형 또는 지수 램프라면,

-

\(E_2\)를 \(t_c\)에서 끝나는 동일 종류의 램프로 재작성하며, 종료값은 원래 램프의 \(t_c\) 시점 값으로 합니다.

-

5단계로 이동.

-

-

그 외에는 4단계로 이동.

-

-

\(E_1\)이 존재한다면:

-